Gpu up

Об этом сейчас говорят все, но мало кто копает вглубь. GPU up — это не просто вставить карточку в слот и радоваться цифрам. Это процесс, часто с подводными камнями, о которых умалчивают в глянцевых обзорах. Многие думают, что дело только в железе, но ключ часто лежит в связке с платформой, питанием, да даже в прошивке материнки. Сейчас поясню на примерах из практики.

Разбор термина: больше, чем апгрейд

Когда я слышу 'нужно сделать GPU up', первое, что приходит в голову — это комплексная оценка системы. Нельзя взять RTX 4090 и воткнуть её в старый ПК с блоком питания на 500 Вт. Будет classic bottleneck, но не только со стороны процессора. Шина, тепловыделение, даже качество сборки корпуса — всё играет роль.

Вот, к примеру, был проект для одного инженерного расчёта. Заказчик хотел 'максимальный GPU up' для ускорения рендеринга. Купили топовую карту, а прирост оказался 15-20%, что странно. Стали разбираться. Оказалось, софт был сильно завязан на single-thread CPU performance, а видеокарта простаивала. Пришлось пересматривать весь стек ПО. Так что сам по себе GPU up без анализа workloads — деньги на ветер.

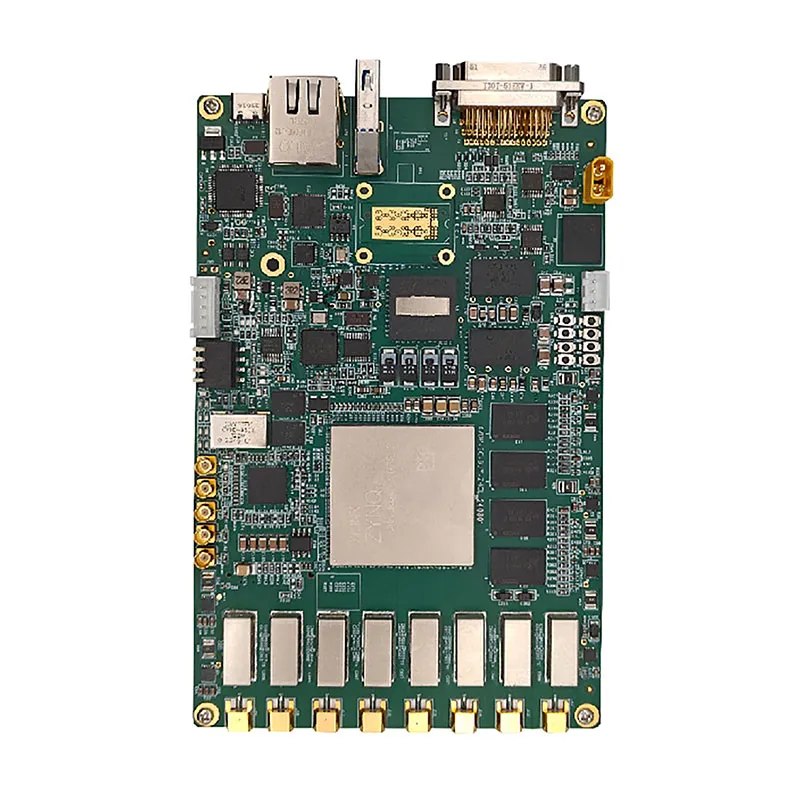

Или другой случай: ребята из ООО 'Сиань Циюнь Чжисюнь Электронные Технологии' (их сайт apexpcb-cn.ru я иногда смотрю для вдохновения по компоновке плат) как раз сталкиваются с подобным на уровне интеграции. Их работа — это создание комплексных электронных решений, где видеоподсистема должна быть не просто мощной, но и правильно встроенной в общую схему питания и управления. Просто воткнуть мощный GPU в их продукты — значит нарушить тепловой баланс и надёжность всей сборки. Их подход к инновациям в электронных схемах — хороший пример системного мышления.

Железо и его скрытые нюансы

Возьмём конкретное железо. Допустим, выбор пал на NVIDIA A100 для дата-центра. Казалось бы, бери и ставь. Но тут встаёт вопрос cooling. Пассивное или активное? Если активное, то как это согласуется с общим airflow в стойке? Однажды видел, как из-за неправильного направления потока в серверном шкафу соседний коммутатор начал перегреваться после GPU up на соседнем блейде. Мелочь, а приводит к downtime.

Питание — отдельная песня. Современные карты требуют стабильных 12V с низкой пульсацией. Дешёвый или старый блок питания может формально выдавать нужные ватты, но под нагрузкой просадят напряжение. Это ведёт не только к троттлингу, но и к долгосрочной деградации компонентов, особенно памяти GDDR6X. Проверял осциллографом — картина бывает удручающая.

И не забываем про рейзеры (riser cables). Казалось бы, простой кабель. Но если он PCIe 4.0, а материнка или карта чуть капризничают с сигналом, получаем ошибки CRC, снижение производительности или вообще чёрный экран. Приходится перебирать, иногда даже понижать линк до Gen3 для стабильности. Это тот самый компромисс, о котором не пишут в мануалах.

Софт и драйверы: невидимый фронт работ

Апгрейд железа — это только полдела. Дальше начинается танцы с драйверами. Особенно в Linux-среде для вычислений. Установил последний драйвер от NVIDIA — а CUDA toolkit от определённого научного пакета с ним не дружит. Приходится катить назад, искать совместимую версию. Или история с ROCm от AMD: вроде заявлена поддержка карты, а на практике для нужной модели приходится собирать ядро с патчами.

Вот здесь опыт компаний, которые занимаются глубокой интеграцией, как та же ООО 'Сиань Циюнь Чжисюнь Электронные Технологии', очень показателен. Их сила в том, что они контролируют целый спектр предприятий по цепочке. Они могут тестировать и валидировать связку 'железо-софт' на более ранних этапах, подбирая драйверы и firmware для конкретного применения. Это даёт им преимущество перед тем, кто просто собирает ПК из готовых компонентов. Их экосистема позволяет увидеть проблему до того, как она дойдёт до конечного пользователя.

Памятный случай: настраивали кластер для машинного обучения. После GPU up (поставили дополнительные карты) один из узлов начал периодически 'вылетать' из задачи. Логи ничего явного не показывали. Долго искали, оказалось — конфликт версий библиотек cuDNN между разными контейнерами Docker. Системный администратор поставил новую версию глобально, а в старом контейнере была зашита своя. Мелочь, которая стоила двух дней простоя.

Провалы и уроки: когда GPU up не сработал

Было и такое. Заказчик экономил и решил сделать GPU up на старых рабочих станциях, купив б/у карты для майнинга. В теории — удешевление. На практике — карты с убитой памятью и высохшими термопрокладками. Первые две недели работали, потом начались артефакты, потом отвал чипа. Восстановление дороже, чем новая карта эконом-класса. Вывод: экономия на этапе апгрейда часто выходит боком. Особенно с учетом нынешних цен на электронику.

Другой провал — неправильная оценка тепловыделения. Поставили в плотный 2U сервер две мощные карты с blower-кулерами. В спецификациях TDP укладывался в cooling capacity корпуса. Но на деле горячий воздух не успевал эффективно отводиться, карты упирались в температурный лимит и сбрасывали частоты. Фактическая производительность была ниже заявленной на 30%. Пришлось переделывать весь шасси, добавлять более мощные вентиляторы, что увеличило шум и стоимость. Иногда правильный GPU up — это сначала апгрейд системы охлаждения.

Или кейс с виртуализацией. Хотели раздать ресурсы одной мощной карты (vGPU) нескольким виртуальным машинам для удалённых рабочих мест. Всё настроили, но latency оказалась слишком высокой для интерактивной работы с графикой. Пользователи жаловались на 'залипания'. Проблема была не в мощности GPU, а в задержках шины и софтверном стеке гипервизора. Пришлось пересматривать архитектуру и ставить отдельные карты на ключевые машины. Дорого, зато работает.

Взгляд в будущее: куда движется апгрейд

Сейчас тренд — не просто raw power, а эффективность и специализация. Тот же NVIDIA Hopper архитектура — это не только терафлопсы, но и трансформерные двигатели, оптимизированные под ИИ. Значит, и подход к GPU up меняется. Теперь нужно спрашивать не 'насколько мощная карта?', а 'под какие конкретные алгоритмы и frameworks она оптимизирована?'.

Интеграция на уровне плат, как это делает группа компаний, включая ООО 'Сиань Циюнь Чжисюнь Электронные Технологии', становится ключевой. Их способность управлять несколькими предприятиями по цепочке создания стоимости позволяет проектировать платы и системы сразу с расчётом на будущий апгрейд графических модулей, предусматривая резерв по питанию, охлаждению и пропускной способности шин. Это уже не реактивный, а проактивный подход.

Лично я сейчас смотрю в сторону CXL (Compute Express Link). Эта технология может в корне изменить то, как мы делаем апгрейд. Возможность более гибко подключать акселераторы, возможно, сделает классический GPU up через слот PCIe чем-то вроде старого доброго IDE-шлейфа. Но это пока горизонт планирования. Пока же работаем с тем, что есть: тщательно тестируем связки, не верим маркетинговым цифрам на слово и всегда закладываем время на отладку. Потому что поднять видеокарту — это часто значит поднять всю систему вокруг неё.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

Обработка и отслеживание изображений

Обработка и отслеживание изображений -

От печатной платы до готового продукта: комплексные решения для производства электроники

От печатной платы до готового продукта: комплексные решения для производства электроники -

AI-будильник

AI-будильник -

16T16R полностью цифровая РЛС Ka-диапазона

16T16R полностью цифровая РЛС Ka-диапазона -

Бортовая РЛС Ka-диапазона

Бортовая РЛС Ka-диапазона -

Услуги по разработке индивидуальных решений

Услуги по разработке индивидуальных решений -

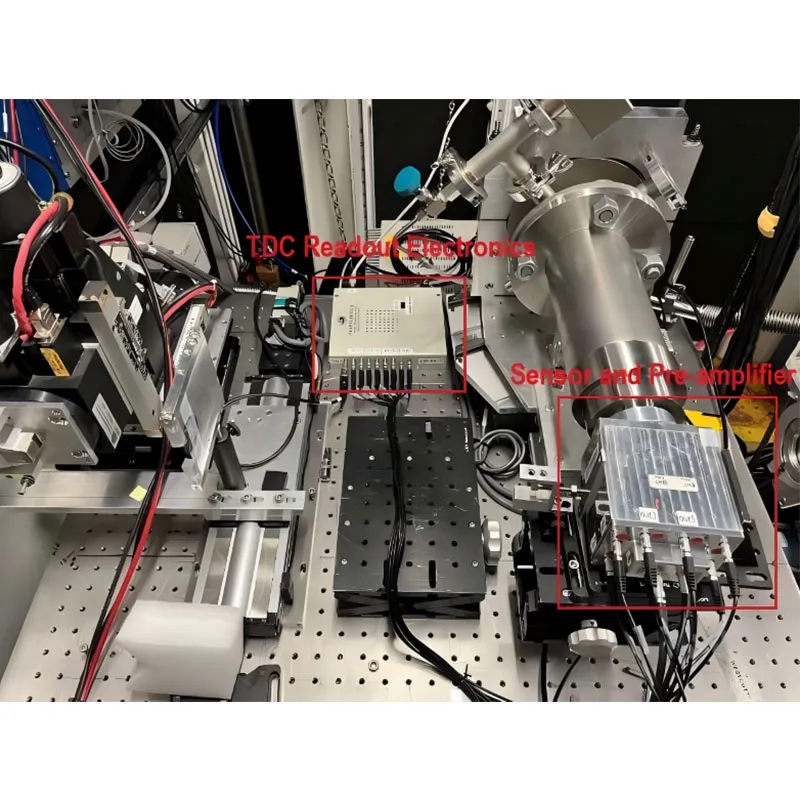

Система измерения времени (YM_TDC)

Система измерения времени (YM_TDC) -

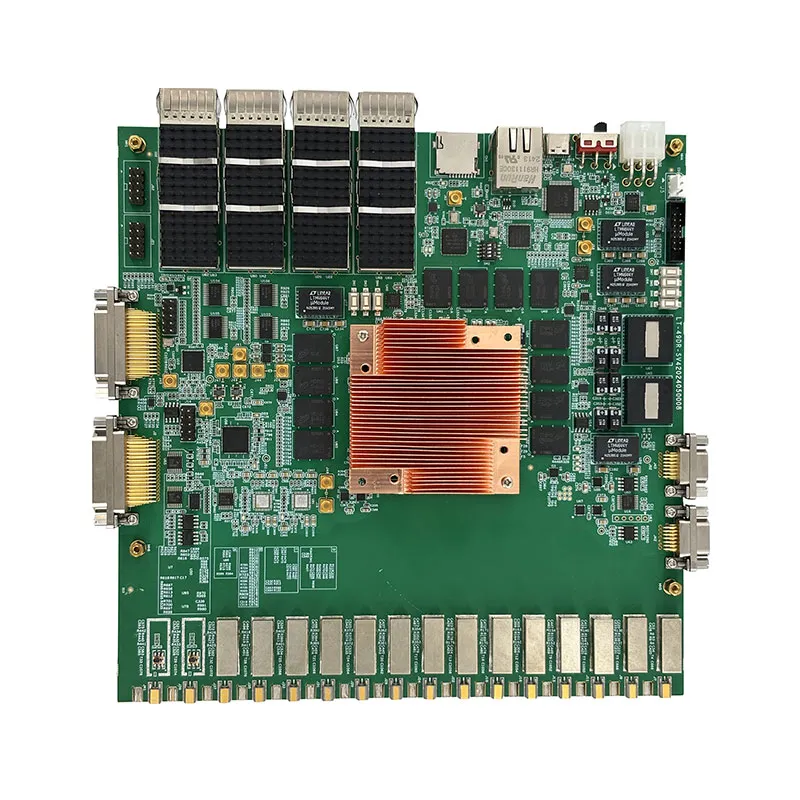

49DR_SV3

49DR_SV3 -

Панорамная разведывательная система

Панорамная разведывательная система -

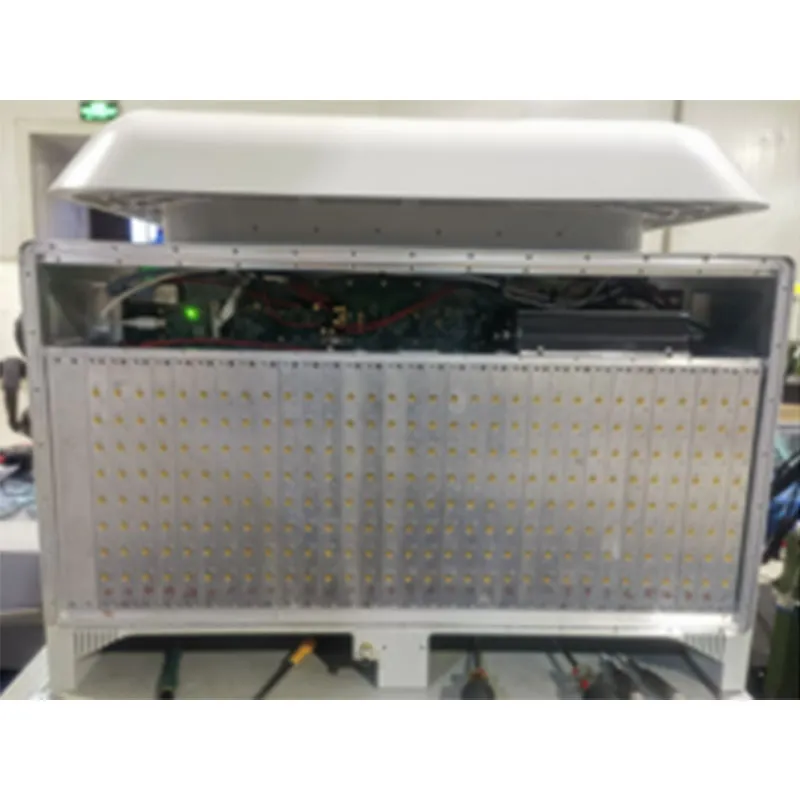

96-канальная цифровая фазированная решётка NLY-96DBF-V1.0

96-канальная цифровая фазированная решётка NLY-96DBF-V1.0 -

192-канальная микроволновая фотонная СВЧ-система прямой выборки NYL

192-канальная микроволновая фотонная СВЧ-система прямой выборки NYL -

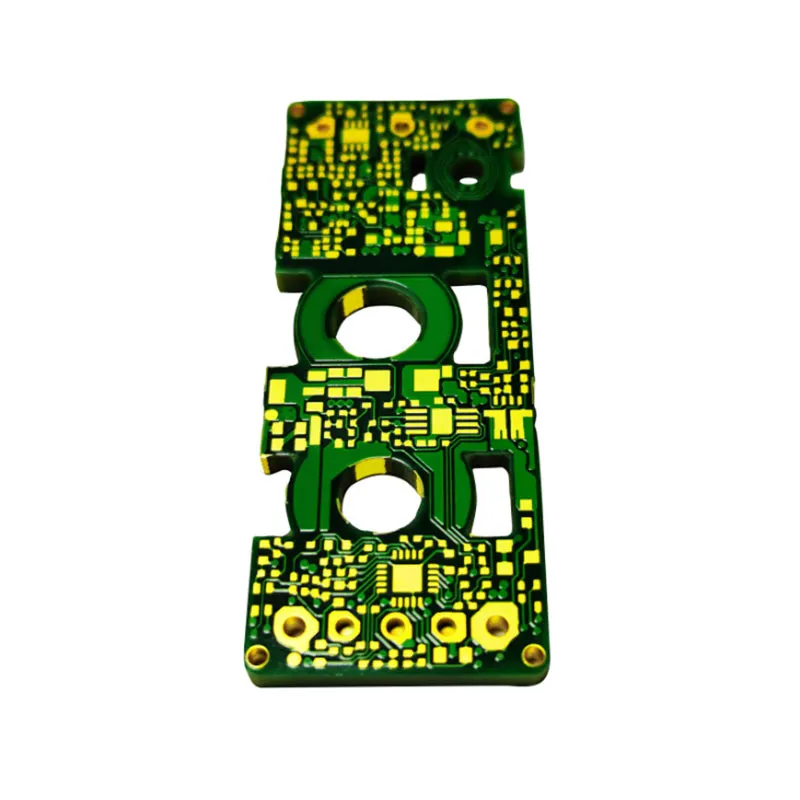

Производство и обработка PCB и SMT

Производство и обработка PCB и SMT