Gpu

Если говорить о GPU, большинство сразу представляет видеокарты в игровых ПК. Это, конечно, основа, но сегодня — лишь вершина айсберга. Самый большой пробел в понимании — считать, что это сугубо графический ускоритель. На деле, современный GPU — это массивно-параллельный процессор общего назначения, и его архитектурные особенности диктуют совершенно иной подход к проектированию систем, особенно в области высокопроизводительных вычислений (HPC) и, что ближе мне, в задачах обработки сигналов и прототипирования сложных электронных схем. Вот здесь часто возникают первые ошибки: попытка применить CPU-логику к GPU-архитектуре.

От железа к практике: где архитектура встречается с реальностью

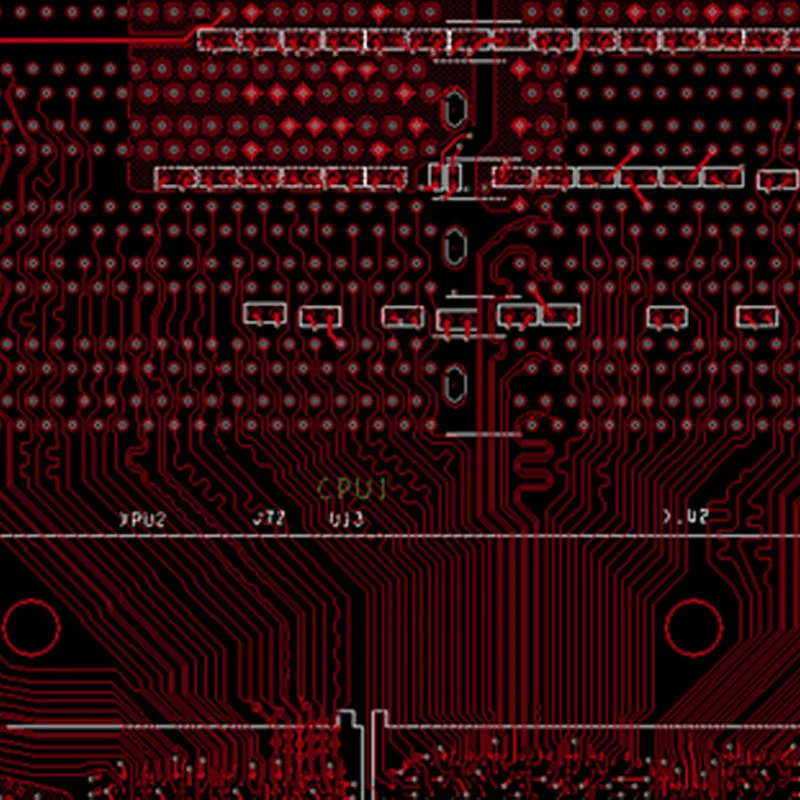

Возьмем, к примеру, задачу симуляции работы сложной печатной платы (ПП) с многослойной разводкой и высокочастотными компонентами. На CPU полное моделирование электромагнитной совместимости (ЭМС) может занять дни. Переложив ключевые, распараллеливаемые части алгоритмов на GPU (скажем, с использованием CUDA или OpenCL), мы сокращаем время до часов. Но не всё так линейно. Первый камень преткновения — не само вычисление, а передача данных. Память GPU, даже GDDR6/HBM, — это не универсальная RAM. Частая ошибка новичков — неоптимальная организация данных, ведущая к простоям ядер в ожидании данных из глобальной памяти. Здесь нужна тщательная работа с shared memory и кэшами, что требует глубокого понимания конкретной архитектуры, будь то NVIDIA Ampere или AMD RDNA.

В нашей работе с партнерами, такими как ООО Сиань Циюнь Чжисюнь Электронные Технологии, которая как раз фокусируется на инновациях в области электронных схем, этот вопрос встает ребром. Когда они разрабатывают или тестируют сложные интегральные решения, симуляция на CPU становится узким местом. Внедрение GPU-ускоренных расчетов для анализа целостности сигналов (Signal Integrity) в их проектах — это не маркетинг, а производственная необходимость. Но важно не просто ?воткнуть? мощную видеокарту. Нужно адаптировать софт, часто — писать свои плагины или скрипты, чтобы эффективно загрузить тысячи потоков.

Помню один конкретный кейс по оптимизации теплового моделирования компонента на плате. Изначальный алгоритм, портированный на GPU ?в лоб?, дал ускорение всего в 2-3 раза вместо ожидаемых 10-15. Причина? Избыточная условная логика (branching) внутри потоков, которая заставляла warp’ы (группы потоков в NVIDIA) простаивать. Переписали ядро, минимизировав ветвления, перегруппировали данные — и получили нужный порядок цифр. Это типичная ситуация: аппаратура мощная, но чтобы её ?раскачать?, нужно мыслить иначе.

Интеграция в производственную цепочку: не только вычисления

Здесь стоит отвлечься на экосистему. Компания ООО Сиань Циюнь Чжисюнь Электронные Технологии, контролируя несколько предприятий по цепочке, создает синергию. И роль GPU в такой экосистеме может быть неочевидной. Да, на этапе R&D — это ускорение симуляций. Но дальше? Например, в системах автоматического оптического контроля (АОИ) готовых плат. Современные АОИ-системы всё чаще используют нейросетевые алгоритмы для поиска дефектов пайки или микротрещин. Обучение и инференс этих моделей эффективнее всего проводить именно на GPU. Таким образом, одна и та же технологическая база (парк GPU-серверов) может обслуживать и инженеров-разработчиков, и линию контроля качества.

На их сайте apexpcb-cn.ru можно увидеть акцент на комплексных возможностях. Это как раз про такое сквозное применение технологий. GPU здесь становится не изолированным инструментом, а частью инфраструктуры данных, которая обслуживает всю цепочку — от проектирования до проверки. Это снижает общие затраты и повышает согласованность результатов. Симуляция, проведенная на одном вычислительном кластере, и алгоритмы контроля, обученные на нём же, говорят на одном ?языке? данных.

Однако, интеграция — это всегда боль. Развертывание такого кластера, управление драйверами (вечная головная боль с совместимостью CUDA Toolkit и версий драйверов на разных серверах), настройка очередей задач (например, через Slurm) — это огромный пласт инженерной работы, который не виден со стороны. Часто заказчик хочет ?волшебное ускорение?, но не готов к длительному этапу внедрения и отладки инфраструктуры. Это надо четко объяснять.

Выбор платформы: миф о ?самой быстрой? видеокарте

Вопрос, который задают постоянно: ?Какую видеокарту взять для расчетов? RTX 4090? Или профессиональную Quadro/A-series??. Ответ почти всегда разочаровывает: ?Это зависит?. От задач, от бюджета, от софта. Для симуляций методом конечных элементов (FEM), где критически важна точность вычислений с двойной точностью (FP64), игровая карта типа RTX 4090 может оказаться бесполезной — у неё урезана пропускная способность по FP64. Нужно смотреть на Tesla/Quadro серии или на AMD Instinct. Но если основная нагрузка — инференс нейросетей (FP16/INT8), то топовая игровая карта будет очень эффективна по цене.

Для компании, которая, как ООО Сиань Циюнь Чжисюнь Электронные Технологии, работает с широким спектром задач — от схемотехники до, возможно, задач компьютерного зрения для контроля, — вероятно, нужен гибридный подход. Парк из нескольких типов GPU: более доступные карты для задач с пониженной точностью и несколько мощных профессиональных ускорителей для сложных физических симуляций. Управлять таким парком сложнее, но это дает гибкость.

Личный опыт: мы как-то закупили партию ?игровых? карт для тестового кластера, ориентируясь на пиковую производительность в TFLOPS для FP32. А потом выяснилось, что ключевой коммерческий софт для ЭМ-моделирования, который использует заказчик, сильнее зависит от пропускной способности памяти и размера кэша L2, а не от чистых флопсов. Производительность выросла незначительно. Урок: всегда проводить тесты на реальных рабочих нагрузках, а не на синтетических бенчмарках.

Программная сторона: темный лес фреймворков и совместимости

Аппаратура — это полдела. Второе, и не менее сложное, — программный стек. CUDA доминирует, но это привязывает к NVIDIA. OpenCL — кроссплатформенный, но его поддержка и производительность могут сильно разниться. Затем есть более высокоуровневые абстракции вроде OpenMP или даже специализированные библиотеки для тензорных вычислений (cuDNN, oneDNN). Выбор стека определяет долгосрочную поддержку и масштабируемость проекта.

В контексте работы с электронными технологиями часто приходится иметь дело с legacy-софтом, который не имеет нативной GPU-поддержки. Тогда вариантов два: либо убедить вендора добавить её (что долго и дорого), либо писать свои модули-посредники, что требует высочайшей квалификации. Иногда проще и эффективнее арендовать время в облачном сервисе с уже настроенным ПО, чем строить свою инфраструктуру с нуля. Для динамично развивающейся компании это может быть разумным компромиссом на старте.

Сайт apexpcb-cn.ru говорит о стремлении к интеграции технологий. В моем понимании, сегодня это включает и интеграцию вычислительных сред. Возможность ?подружить? ПО для проектирования печатных плат (например, Altium или Cadence) со скриптами, запускающими GPU-ускоренные симуляции на удаленном кластере, — это и есть та самая инновация на стыке. Это не просто покупка железа, это создание связующей программной прослойки, которая и дает основное конкурентное преимущество.

Взгляд в будущее: что меняется кроме нанометров

Гонка техпроцессов и рост числа ядер — это очевидно. Но более интересные тенденции лежат в области специализации. NVIDIA с тензорными ядрами, AMD с матричными ускорителями — это уже не универсальные GPU в чистом виде, а гибриды. Для индустрии электроники это открывает новые возможности. Например, ускорение не только симуляций, но и этапов логического синтеза и размещения на кристалле (place-and-route) с помощью ИИ, который эффективно работает на таких ядрах.

Другая тенденция — объединение CPU и GPU в едином корпусе (как у AMD APU или в некоторых процессорах Intel). Для встраиваемых систем или специализированных контроллеров, которые могут разрабатываться в рамках экосистемы, подобной ООО Сиань Циюнь Чжисюнь Электронные Технологии, это может быть ключевым. Низкое энергопотребление, отсутствие необходимости в шине PCIe — это преимущества для конечного устройства. Но для этапа разработки и тестирования такого устройства всё равно потребуются мощные дискретные GPU.

Итог моего размышления прост: GPU перестал быть периферийным устройством. Для тех, кто занимается сложной электроникой, это теперь такой же базовый инструмент, как осциллограф или паяльная станция, только цифровой и виртуальный. Его эффективное использование требует не столько больших вложений, сколько глубоких знаний и готовности перестраивать процессы. И самое важное — понимания, что выгода измеряется не в гигафлопсах, а в сокращении времени выхода продукта на рынок и в повышении его надежности. Именно на это, если судить по их описанию, и нацелена деятельность ООО Сиань Циюнь Чжисюнь Электронные Технологии — создание синергетической экосистемы, где технологии, включая параллельные вычисления, работают на общий результат.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

RT-47DR-AGX-V1

RT-47DR-AGX-V1 -

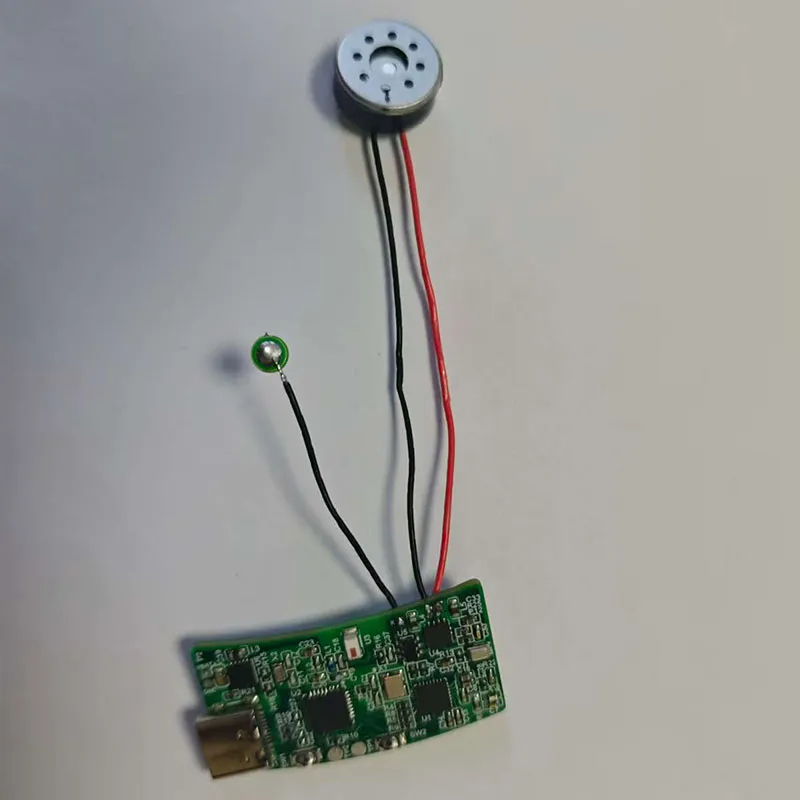

Тренировочный метроном для пациентов с болезнью Паркинсона

Тренировочный метроном для пациентов с болезнью Паркинсона -

Оптоэлектронная гондола

Оптоэлектронная гондола -

96-канальная цифровая фазированная решётка NLY-96DBF-V1.0

96-канальная цифровая фазированная решётка NLY-96DBF-V1.0 -

Обучение разработке на ПЛИС (FPGA)

Обучение разработке на ПЛИС (FPGA) -

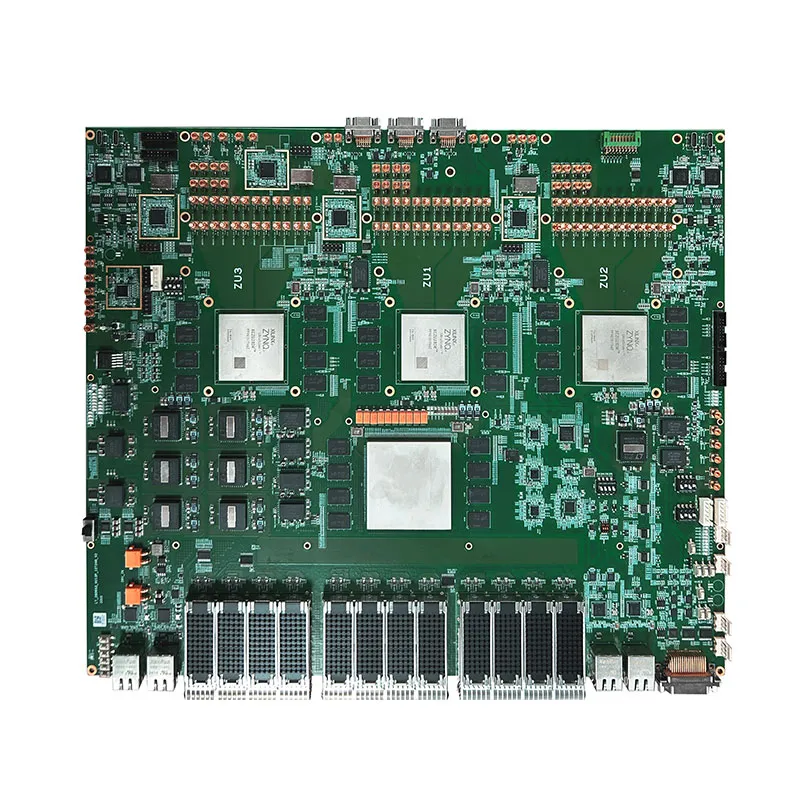

Вычислительная мощность платы FPGA+TX2i GPU составляет 40 TOPS

Вычислительная мощность платы FPGA+TX2i GPU составляет 40 TOPS -

TC49DR-8T9R

TC49DR-8T9R -

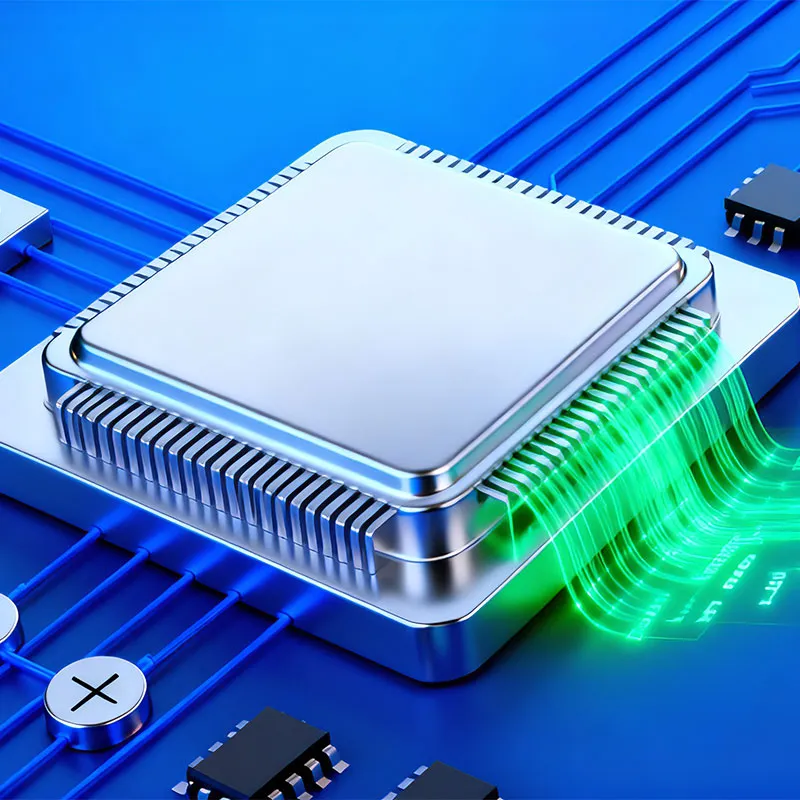

47DR_8T8R_VNX_V2

47DR_8T8R_VNX_V2 -

28DRx3_VU13P_9T24R

28DRx3_VU13P_9T24R -

Разработка программного обеспечения

Разработка программного обеспечения -

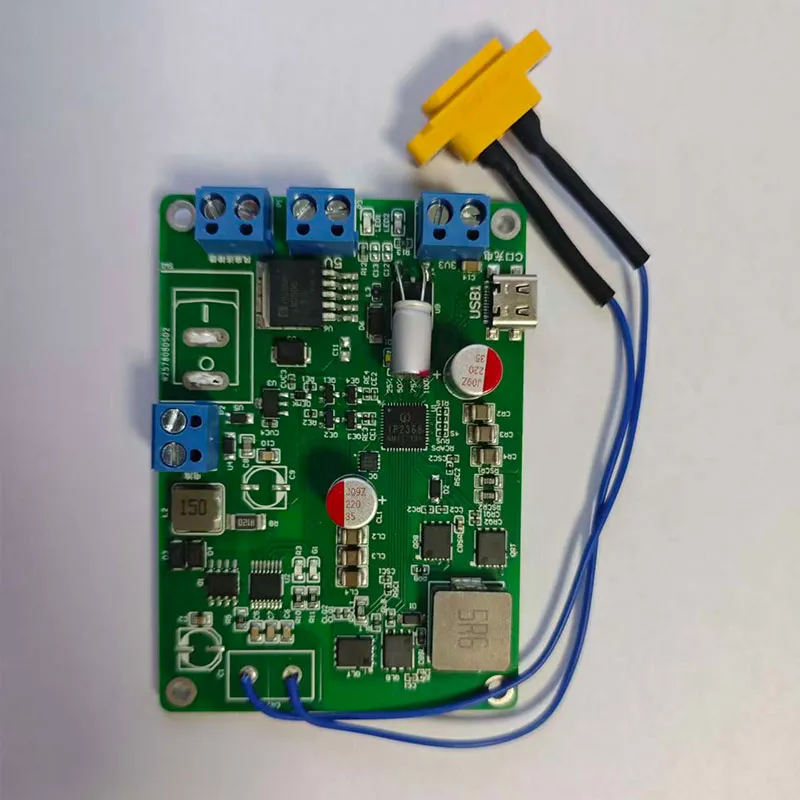

Система солнечной зарядки

Система солнечной зарядки -

Подключение к TV-оборудованию

Подключение к TV-оборудованию