60 gpu

Обзор: Разговор о кластерах в 60 GPU — это не про красивую цифру, а про реальные инженерные подножки, от тепловых завес до сюрпризов с питанием. Здесь делятся опытом, а не спецификациями.

От макета к стойке: где теория трещит по швам

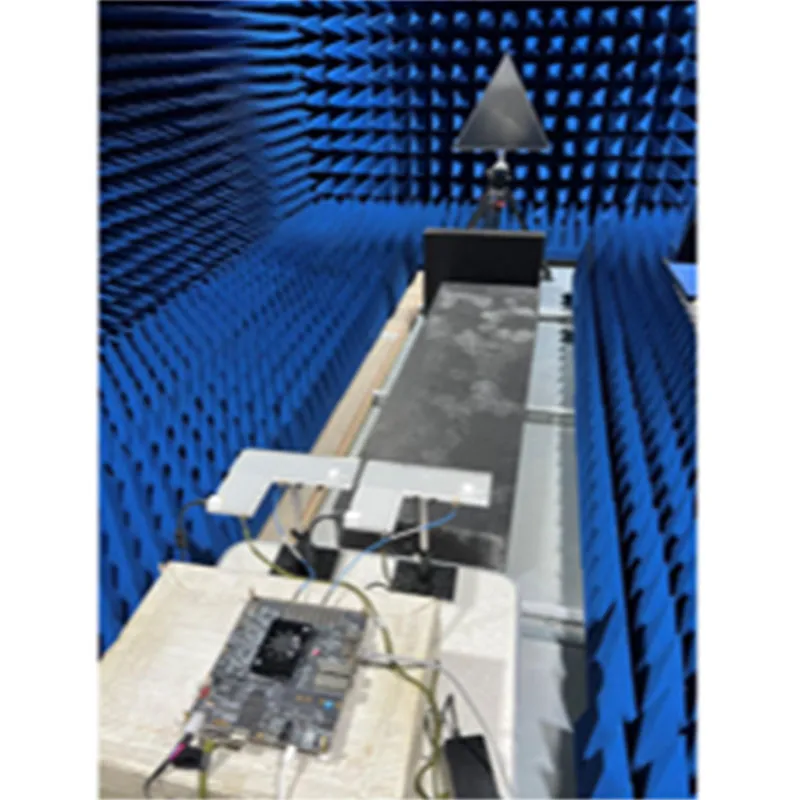

Многие, услышав ?кластер на 60 GPU?, сразу представляют линейку блестящих серверов. На деле, начать лучше с печатной платы. Я видел проекты, где из-за плохой разводки питания на материнской плате под нагрузкой проседали напряжения уже на 40-м ускорителе. Это не ошибка проектирования чипа, это — просчет на уровне системы. Компании вроде ООО ?Сиань Циюнь Чжисюнь Электронные Технологии?, которая как раз занимается интеграцией электронных схем, понимают эту боль. Их работа — сделать так, чтобы силовая электроника на плате держала удар, когда все 60 единиц железа выходят на пиковое потребление. Не просто паять компоненты, а моделировать нагрузочные сценарии. На их сайте apexpcb-cn.ru можно найти кейсы, но суть не в рекламе, а в подходе: без надежной элементной базы вся конструкция хрупка.

Самый частый провал на этапе сборки — недооценка теплового бюджета. 60 GPU — это не 60 умноженное на TDP одной карты. В плотной упаковке возникает эффект рециркуляции горячего воздуха. Однажды пришлось разбирать почти собранную стойку, потому что термодатчики на картах нижнего ряда зашкаливали, хотя общие вентиляторы в дата-центре дули исправно. Пришлось пересматривать всю шассию, добавлять раздельные каналы. Это та самая ?экосистема промышленной цепочки?, о которой говорят интеграторы — проблема решается не заменой кулера, а пересмотром взаимного расположения компонентов, и иногда для этого нужен контроль над смежными производствами, как у упомянутой группы.

И еще по питанию. Блоки на 3 кВт — это стандарт, но когда их нужно несколько на одну систему, возникает вопрос балансировки фаз и отказоустойчивости. Простой параллельное подключение — путь к дребезгу и отключениям. Здесь пригодился опыт коллег, которые делали стенды для тестирования плат. Они использовали кастомные решения по стабилизации, отчасти похожие на те, что нужны для питания кластера. Это к вопросу о синергии: знания из области проектирования печатных плат неожиданно оказываются критичными для построения вычислительных систем.

Программная сторона: драйверы, очереди и ?тихие? сбои

Аппаратура собрана — начинается самое интересное. Попытка поднять кластер на 60 GPU на стандартных драйверах часто упирается в лимиты планировщика. Система видит все устройства, но не может эффективно распределить задачи, особенно в гетерогенной среде (если вдруг использовались карты разных поколений). Приходится лезть в настройки ядра, что само по себе риск.

Одна из самых коварных проблем — так называемые ?тихие? ошибки вычислений (silent data corruption). На одном из проектов по обучению моделей на таком крупном кластере периодически падала точность. Аппаратных сбоев не было, температура в норме. Долго искали, оказалось — сбой в памяти одной из GPU под определенным видом нагрузки. Ее не отключало, но она портила данные. Выловили только путем поэтапного исключения устройств из пула и сравнения результатов. После этого на всех подобных системах внедрили более агрессивный скрининг памяти при старте, хотя это и отнимает время.

Очередь задач — отдельная история. Не все фреймворки для распределенных вычислений одинаково хорошо масштабируются до 60 устройств. Возникают узкие места при синхронизации градиентов. Иногда эффективнее разбить кластер на логические группы по 20-30 GPU и запускать на них независимые эксперименты, чем гнаться за рекордным временем обучения одной модели. Это решение пришло с практикой, а не из документации.

Экономика масштаба: когда 60 — не лучше, чем 50

Здесь кроется главный миф. Заказчики думают: больше GPU — быстрее результат. Но после определенного порога прирост производительности нелинейный. На одном из коммерческих проектов для обработки видео мы вышли на плато: добавление 61-й и 62-й карты дало прирост менее 1% к общей скорости, потому что уперлись в пропускную способность сети между узлами. Пришлось остаться на 60, но с инвестициями в более быстрые межсоединения (InfiniBand вместо Ethernet). Это был дорогой урок.

Стоимость владения — это не только цена железа. Энергопотребление кластера из 60 GPU требует отдельного согласования в дата-центре, а иногда и модернизации подводящих линий. А еще охлаждение. В одном из случаев пришлось заказывать индивидуальный контур жидкостного охлаждения, потому что воздушное не справлялось в летний период, и карты начинали троттлить. Это увеличило сроки развертывания на месяц.

С точки зрения надежности, вероятность отказа одного из устройств в массиве из 60 штук статистически выше. Нужна стратегия горячей замены и избыточность. Мы пробовали конфигурацию, где 2 GPU из 60 были резервными, работающими в облегченном режиме. В случае сбоя основной карты ее нагрузка автоматически перераспределялась. Работало, но добавляло сложности в управлении. Не каждый софт это поддерживает ?из коробки?.

Интеграция в производственную цепочку: пример из практики

Вот где пригождается опыт компаний, которые контролируют несколько звеньев цепи. Представьте задачу: нужно создать систему для симуляции физических процессов, и ключевой модуль — как раз вычислительный кластер. Заказчик хочет, чтобы часть электроники (контроллеры питания, интерфейсные платы) была спроектирована и произведена с учетом специфики остальных компонентов. Это как раз область, где работает ООО ?Сиань Циюнь Чжисюнь Электронные Технологии?. Их сила — не в сборке готовых серверов, а в возможности влиять на дизайн печатных плат и модулей, которые потом стыкуются с GPU. В одном из реальных кейсов, который я видел, именно такая глубокая интеграция позволила уменьшить задержки в обмене данными между вычислительными узлами, потому что интерфейсные платы были ?заточены? под конкретную модель GPU и сетевую карту.

Без такого уровня кооперации между предприятиями внутри холдинга приходится довольствоваться стандартными, не всегда оптимальными решениями. Например, использовать коммерческие материнские платы с избыточным количеством слотов, но с компромиссами в пропускной способности шины. Когда же ты можешь, участвуя в доле предприятий, заказать плату с нужной разводкой PCIe-линий, результат другой. Это и есть та самая ?значительная комплексная возможность?, которая превращает набор из 60 GPU в слаженную систему, а не в простое скопление мощных видеокарт.

В итоге, работа с кластером на 60 GPU — это постоянный баланс между аппаратными пределами, софтверной оптимизацией и экономической целесообразностью. Цифра 60 здесь — просто удобный ориентир, за которым скрывается целый пласт инженерных задач. И успех зависит не от того, сколько железа ты купил, а от того, насколько глубоко ты можешь интегрировать его в работающий технологический процесс, начиная с уровня печатной платы. Именно этим, судя по всему, и занимается упомянутая компания, превращая разрозненные компоненты в работоспособную экосистему.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

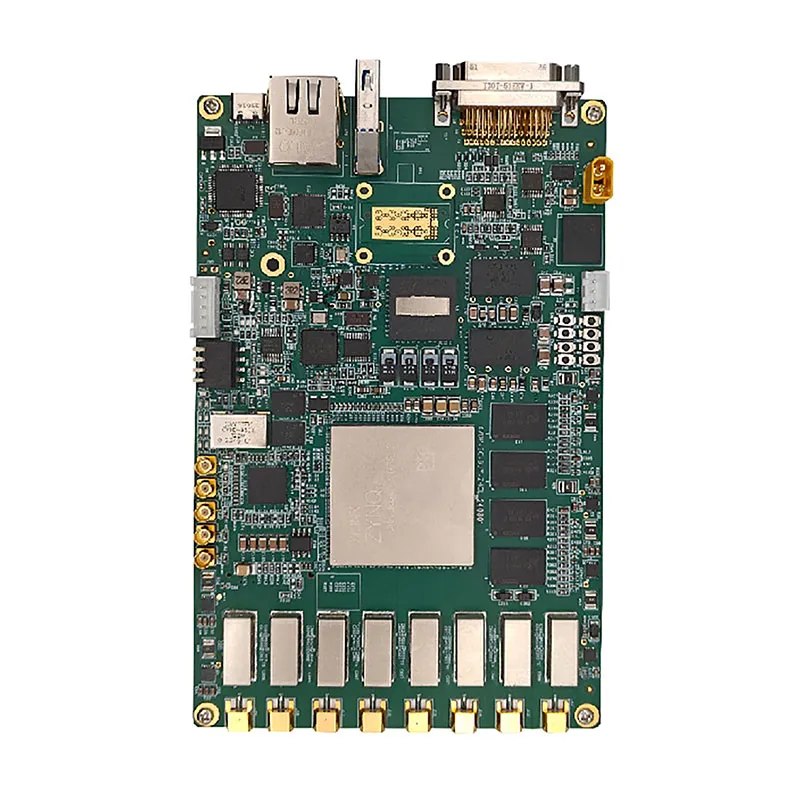

Компьютер QYZX-D20008

Компьютер QYZX-D20008 -

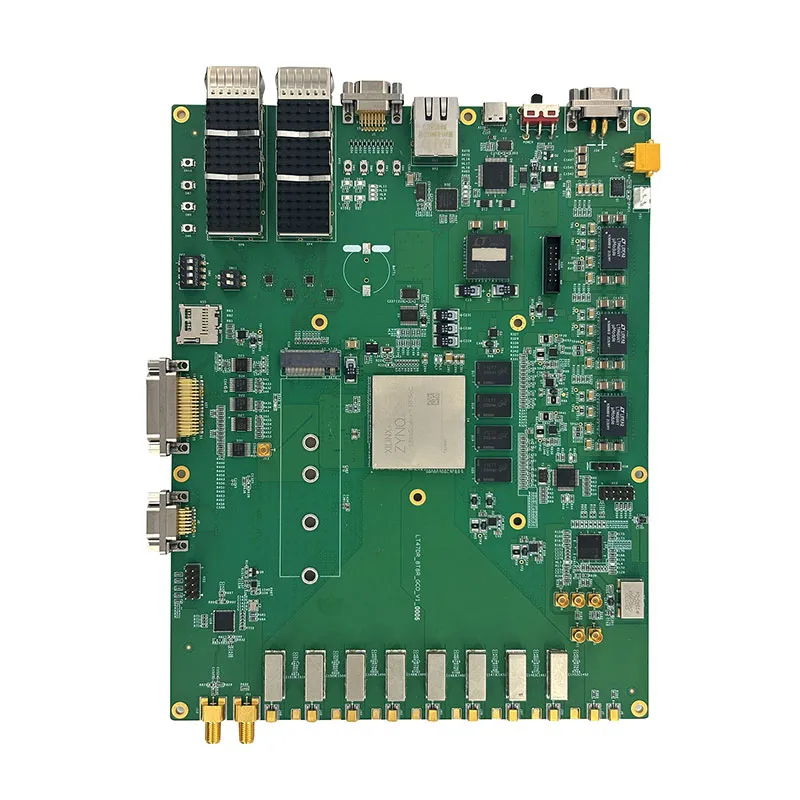

47DR_SC_BJY_ZHCL_240801

47DR_SC_BJY_ZHCL_240801 -

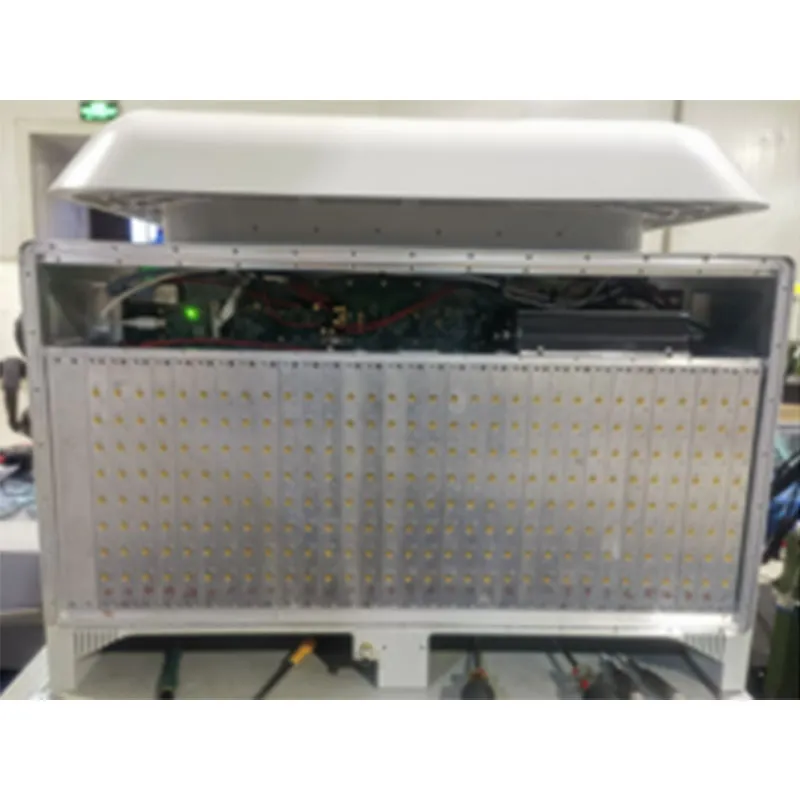

256-канальная цифровая фазированная решётка NYL

256-канальная цифровая фазированная решётка NYL -

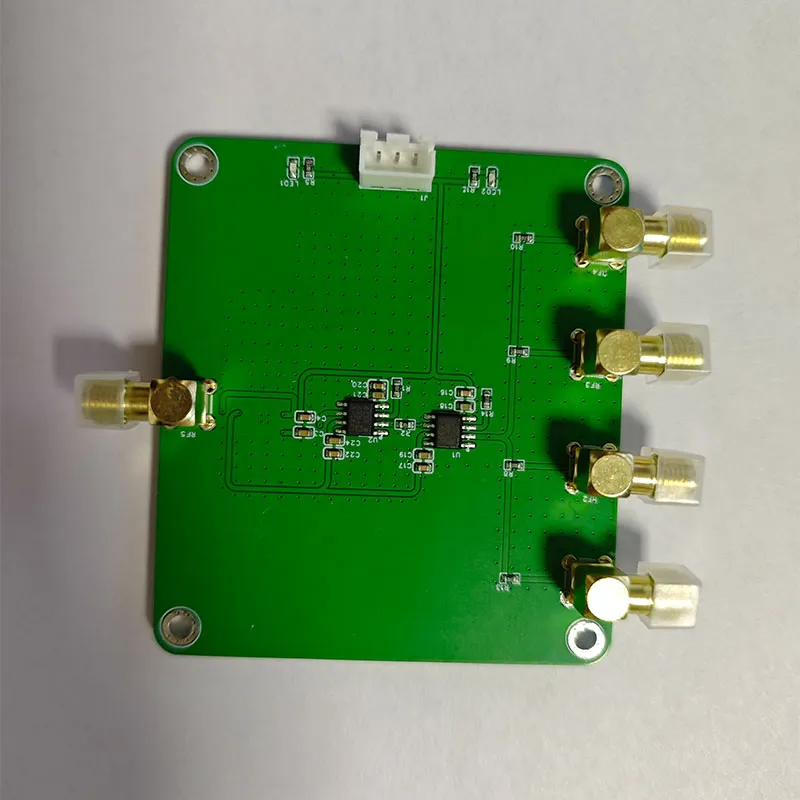

Суммирующий усилитель

Суммирующий усилитель -

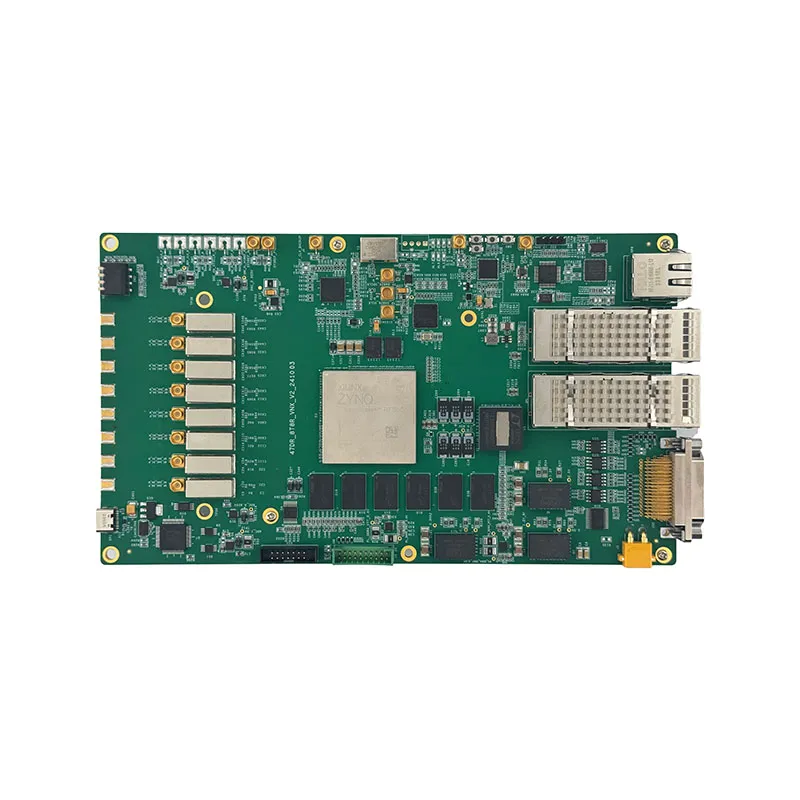

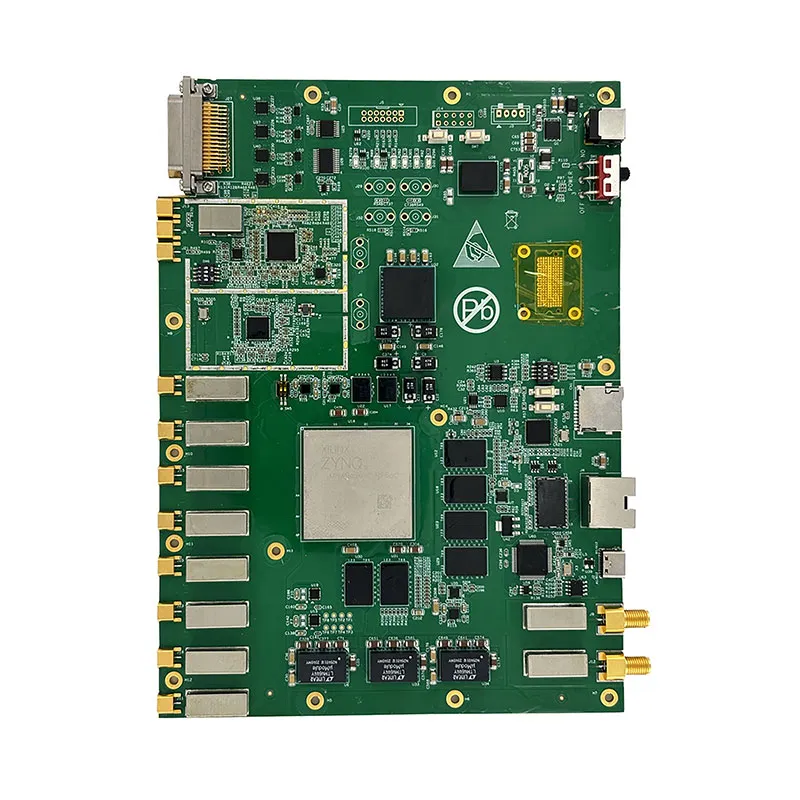

RFSoC-2T8R-47DR

RFSoC-2T8R-47DR -

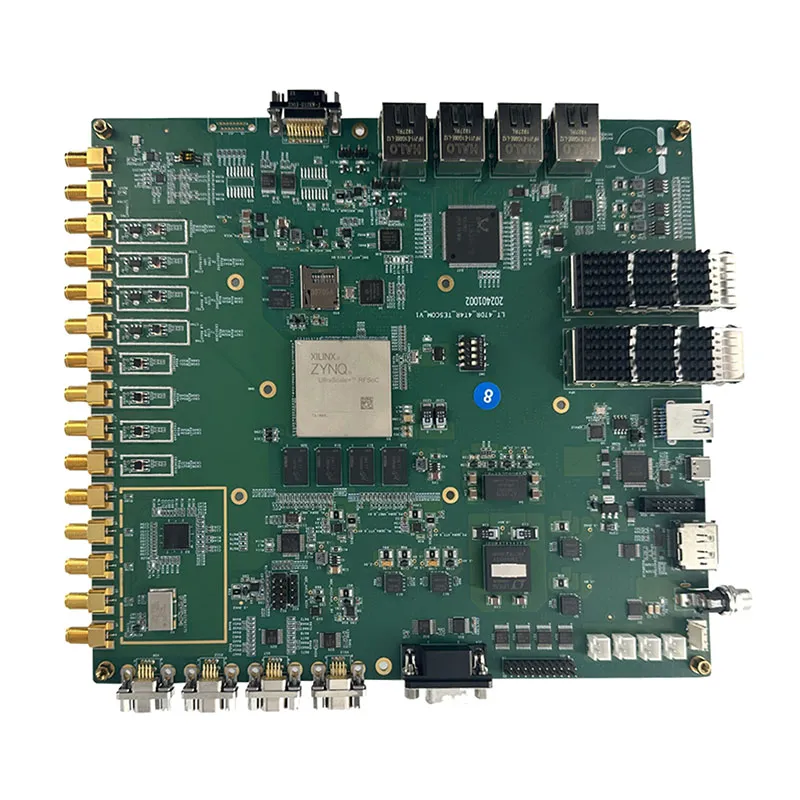

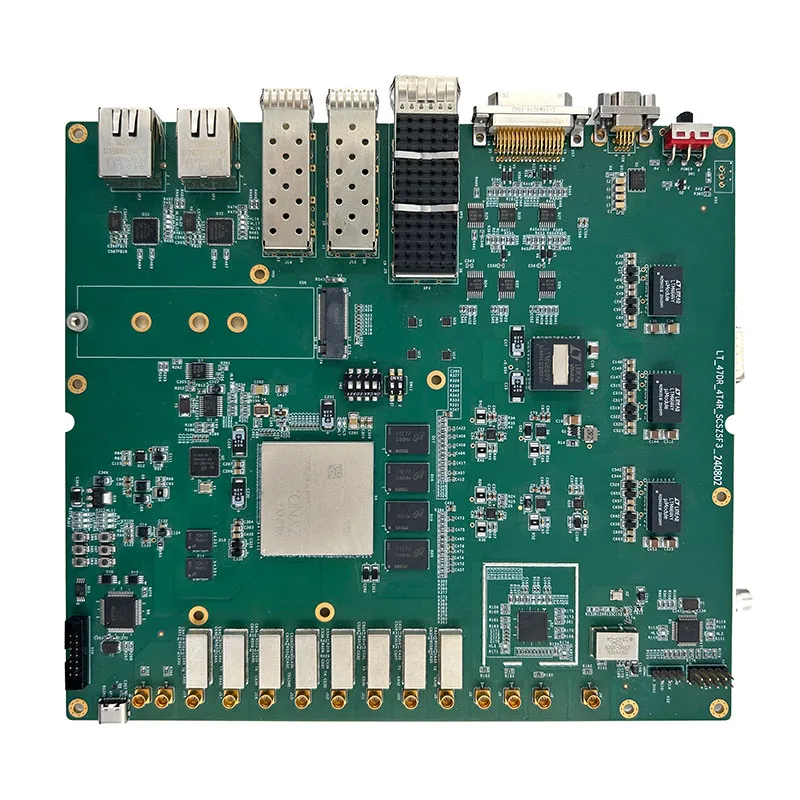

47DR_4T4R_SCSZSF3

47DR_4T4R_SCSZSF3 -

AI-будильник

AI-будильник -

Высокоскоростной регистратор данных

Высокоскоростной регистратор данных -

64-канальное программно-определяемое радио NLY-VNX-64DBF

64-канальное программно-определяемое радио NLY-VNX-64DBF -

RT-47DR-AGX-V1

RT-47DR-AGX-V1 -

Усилитель мощности PA160-220MHz-500W

Усилитель мощности PA160-220MHz-500W -

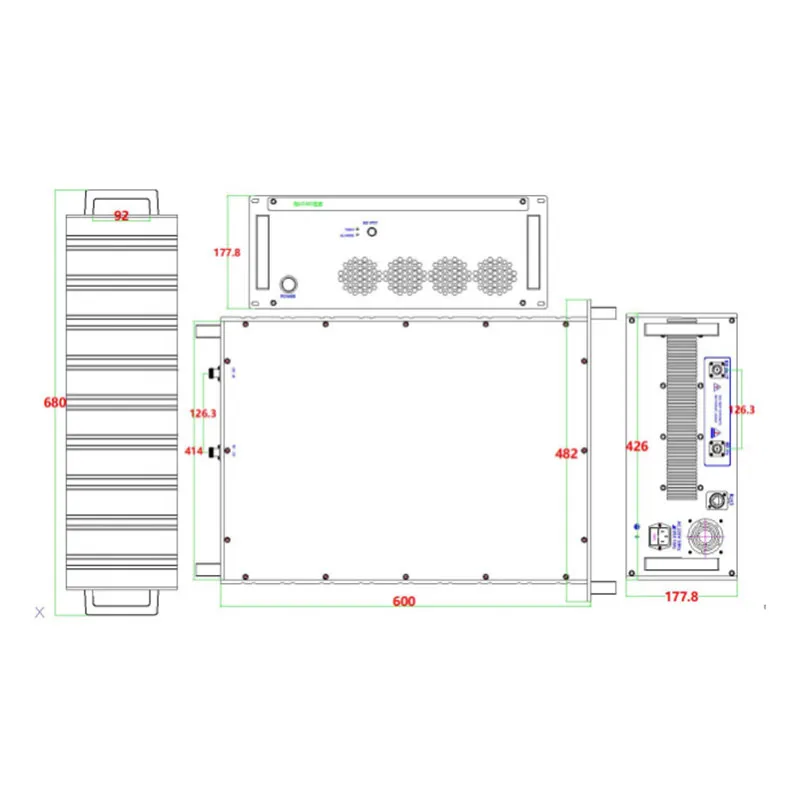

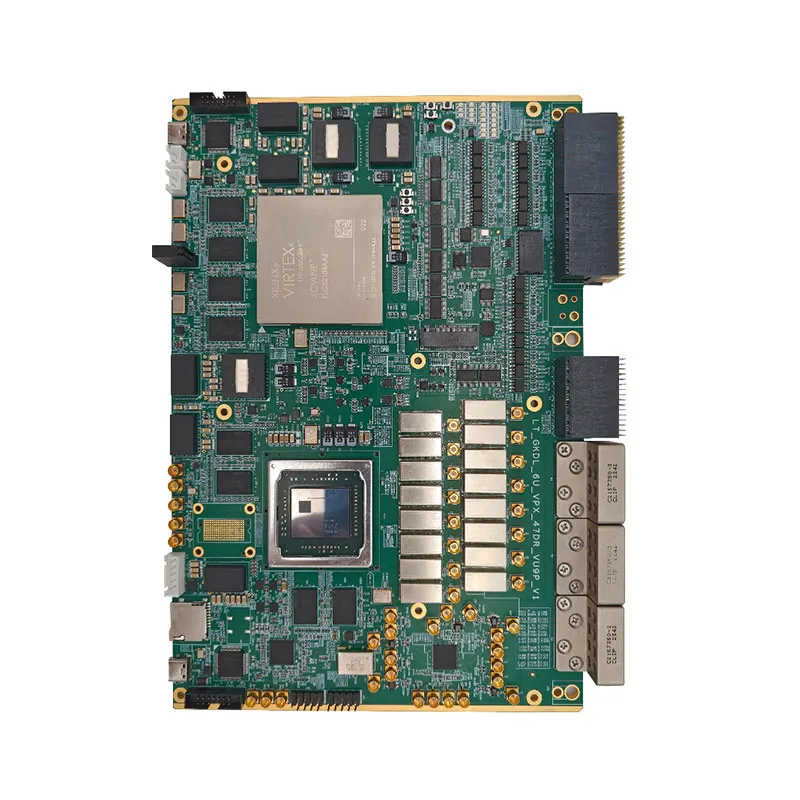

GKDL_6U_VPX_47DR_VU9P_V2

GKDL_6U_VPX_47DR_VU9P_V2