Сервер

Когда говорят ?сервер?, многие представляют себе просто черный ящик в дата-центре. На деле же — это нервный узел, от которого зависит дыхание всей системы. Моя практика показывает, что ключевая ошибка — недооценка его как целостного организма, где железо, софт, среда и нагрузка неразделимы.

От концепции до стойки: где кроются подводные камни

Планирование инфраструктуры часто начинается с красивых цифр на бумаге. Помню проект, где заказчик требовал максимальной отказоустойчивости на базе стандартных двухпроцессорных серверов. На бумаге все сходилось: кластер, репликация, отказные сценарии. Но при детальном разборе нагрузок выяснилось, что пиковые транзакции требуют не столько CPU, сколько низких задержек ввода-вывода и предсказуемой работы сети. Стандартная конфигурация тут не катила.

Пришлось глубоко копать в спецификации контроллеров, прошивках, настройках драйверов. Это та самая ?грязная? работа, которую не видно в презентациях. Выбор пал на платформу с акцентом на каналы PCIe 4.0 и возможность тонкой настройки RAID-контроллера под конкретный тип СХД. Важно было не просто взять ?мощный? сервер, а сопрячь его профиль с профилем задачи.

Тут вспоминается опыт коллег по интеграции с производителями печатных плат. Например, для автоматизированных линий контроля качества на производстве, как у ООО Сиань Циюнь Чжисюнь Электронные Технологии, где важен поток данных с высокоточных камер и датчиков, требования к серверу смещаются в сторону высокой пропускной способности шины и стабильности обработки в реальном времени. Это не типичный корпоративный файл-сервер.

Железо: мифы о надежности и практика эксплуатации

Надежность — это не про MTBF (наработку на отказ) из каталога. Это про то, как ведет себя система при отказе одного из двух блоков питания в час пиковой нагрузки, когда ИБП тоже под нагрузкой. Однажды наблюдал, как ?горячее? резервирование на деле давало просадку по напряжению, что вызывало сбросы на соседнем оборудовании. Причина — не сам сервер, а проектирование всей силовой ветки в стойке.

Компонентная база — отдельная тема. Кажется, что память от известного вендора — гарантия. Но партии чипов меняются, и иногда попадаются модули, которые в конкретной модели материнской платы дают редкие ошибки коррекции (ECC) только под определенной температурой. Выловить такое без долгого стресс-тестирования в условиях, приближенных к ?боевым?, почти невозможно. Поэтому сейчас для критичных задач мы закладываем этап ?обкатки? железа на стенде с циклической термонагрузкой.

В контексте производственных экосистем, подобных той, что выстраивает ООО Сиань Циюнь Чжисюнь Электронные Технологии, где контроль над цепочкой поставок ключевых компонентов — часть стратегии, этот принцип становится еще важнее. Надежность сервера для управления таким производством начинается с надежности каждой микросхемы на его собственной плате.

Программная среда: невидимый каркас

Установил ОС, развернул службы — и готово? Как бы не так. Самый частый косяк — несоответствие уровня драйверов и firmware (прошивок) базовых компонентов. Обновил, скажем, гипервизор для лучшей виртуализации, а драйвер сетевой карты от того же вендора, но более старый, начинает ?ронять? пакеты при высокой нагрузке. Ждешь от вендора патч, а система уже в продуктиве.

Отсюда мое правило: для каждой значимой сборки ПО вести матрицу совместимости, куда вносятся не только версии ОС и гипервизора, но и точные версии прошивок RAID-контроллера, BIOS, BMC, сетевых и дисковых адаптеров. Это скучно, но экономит нервы при масштабировании или аварии. Сервер без этой ?биографии? софта — черный ящик в прямом и переносном смысле.

Особенно критично это для сред, где виртуализация заточена под специфичные задачи, например, для запуска CAD-систем или ПО для трассировки печатных плат. Требования к графическому ускорению, передаче больших данных между ВМ — здесь каждая прослойка софта должна быть выверена.

Мониторинг и обслуживание: предсказать, а не тушить

Штатный мониторинг по SNMP или через агента часто дает лишь общую картину: загрузка CPU, объем свободной памяти. Чтобы увидеть реальные узкие места, нужны кастомные метрики. Например, отслеживание длины очереди дисковых операций на конкретном LUN или задержек (latency) ответа контроллера управления (BMC).

Был случай, когда сервер начал периодически ?подвисать? на несколько секунд. Стандартные дашборды были зелеными. Помогло глубинное логирование: оказалось, что фоновые задачи firmware по сбору телеметрии для вендора конфликтовали по таймингам с работой СХД в определенные часы. Отключили ?удобную? телеметрию — проблема ушла.

Проактивное обслуживание — это еще и понимание жизненного цикла. Диск с предсказанием сбоя (SMART) — это понятно. Но как быть с деградацией конденсаторов на материнской плате или вторичных источниках питания? Тут помогает только регулярный физический осмотр и анализ логов BMC на предмет аномальных колебаний вольтажа по линиям, что часто упускается из виду в удаленных дата-центрах.

Интеграция в экосистему: когда сервер — часть цепочки

Сегодня редко встретишь сервер, работающий в вакууме. Он — звено в цепи. Яркий пример — интеграция в промышленную экосистему, как у упомянутой компании. Их модель, предполагающая контроль над несколькими предприятиями в цепочке создания стоимости, требует от ИТ-инфраструктуры не просто высокой доступности, а детерминированности.

Если сервер, обрабатывающий заказы на производство плат, ?задумается? на полсекунды, это может вызвать каскадный сбой в логистике компонентов на сборочном предприятии, входящем в ту же группу. Здесь важна не только отказоустойчивость на уровне одного ЦОДа, но и геораспределенная архитектура с четкими RPO (целевой точкой восстановления) и RTO (целевым временем восстановления).

Приходилось работать над подобными схемами, где синхронизация данных между серверами на основном и резервном site шла не только на уровне баз данных, но и на уровне файловых хранилищ для конструкторской документации и техпроцессов. Сложность в том, чтобы обеспечить консистентность без потери производительности для инженеров, работающих с тяжелыми файлами. Порой решение лежало в комбинации технологий: синхронная репликация для метаданных и асинхронная — для bulk-данных.

Вместо заключения: мысль вслух

Так что же такое современный сервер? Это не продукт, а процесс. Это постоянный баланс между апгрейдом и стабильностью, между новыми возможностями и проверенной надежностью. Опыт, который нельзя почерпнуть только из мануалов. Он нарабатывается через подобные ситуации, когда стандартный подход дает сбой, и приходится лезть в дебри спецификаций, логировать каждое действие и искать причину на стыке слоев.

Для таких комплексных игроков, как ООО Сиань Циюнь Чжисюнь Электронные Технологии, где технологии электронных схем — это суть бизнеса, этот подход должен быть вдвойне естественным. Потому что их продукт — это тоже сложная система, и от надежности их внутренних серверов зависит надежность плат, которые они производят для других. Замкнутый круг, который нужно делать кругом качества.

Выбор, настройка, эксплуатация — каждый этап требует не слепого следования инструкциям, а критического осмысления и готовности к нестандартным проблемам. И это, пожалуй, самое интересное в работе.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

Высокоскоростной сбор и хранение данных: Прямая запись FPGA в NVMe SSD (восьмидисковый отсек)

Высокоскоростной сбор и хранение данных: Прямая запись FPGA в NVMe SSD (восьмидисковый отсек) -

Двухпроцессорный сервер 3C5000

Двухпроцессорный сервер 3C5000 -

Высокоточная система синхронизации импульсов (YM_SYNC)

Высокоточная система синхронизации импульсов (YM_SYNC) -

AI-будильник

AI-будильник -

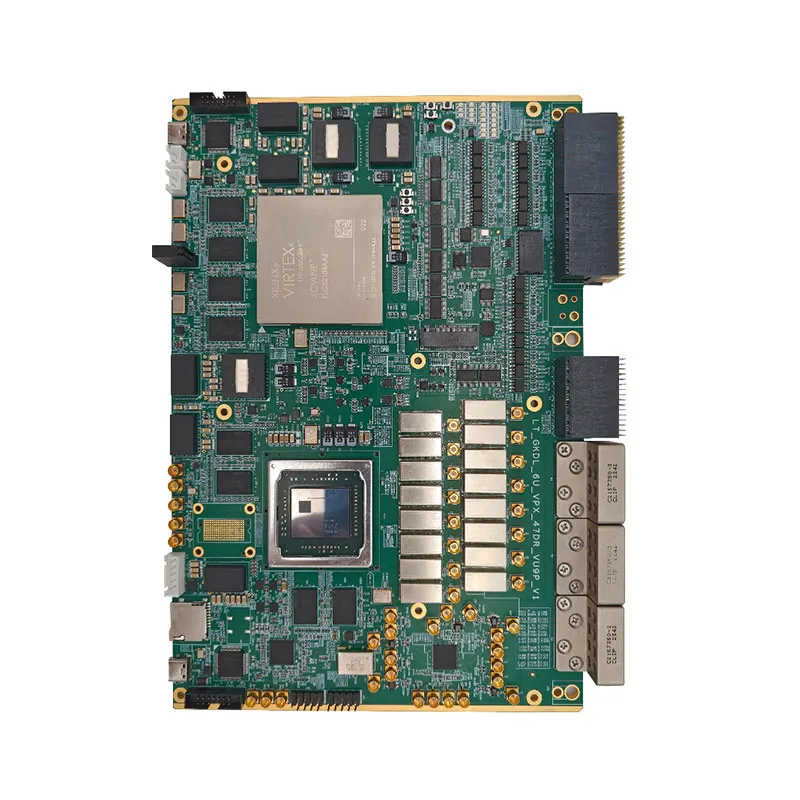

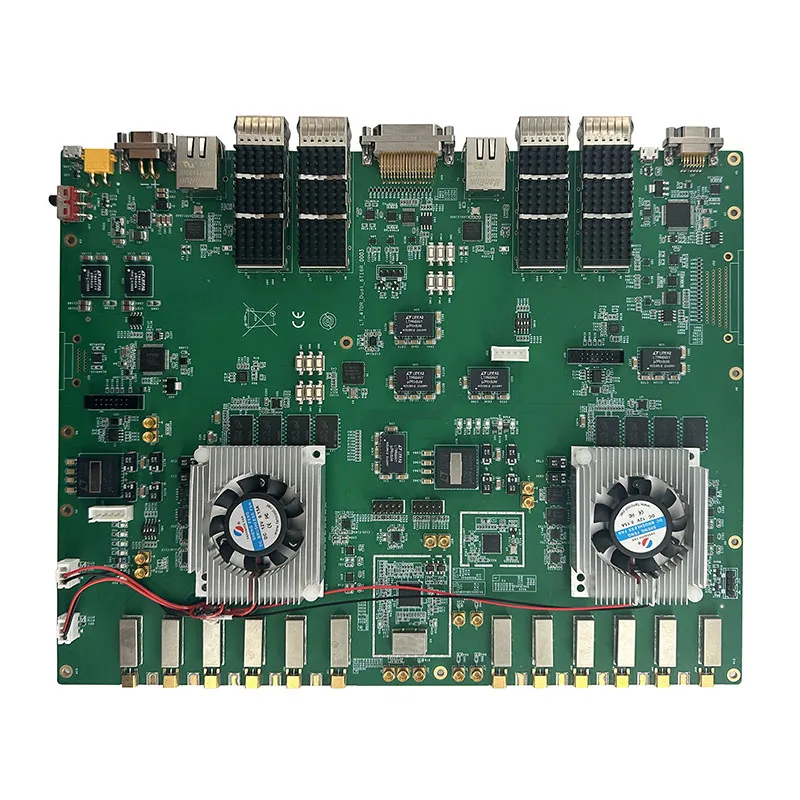

47DR_DUAL_6T16

47DR_DUAL_6T16 -

Подключение к TV-оборудованию

Подключение к TV-оборудованию -

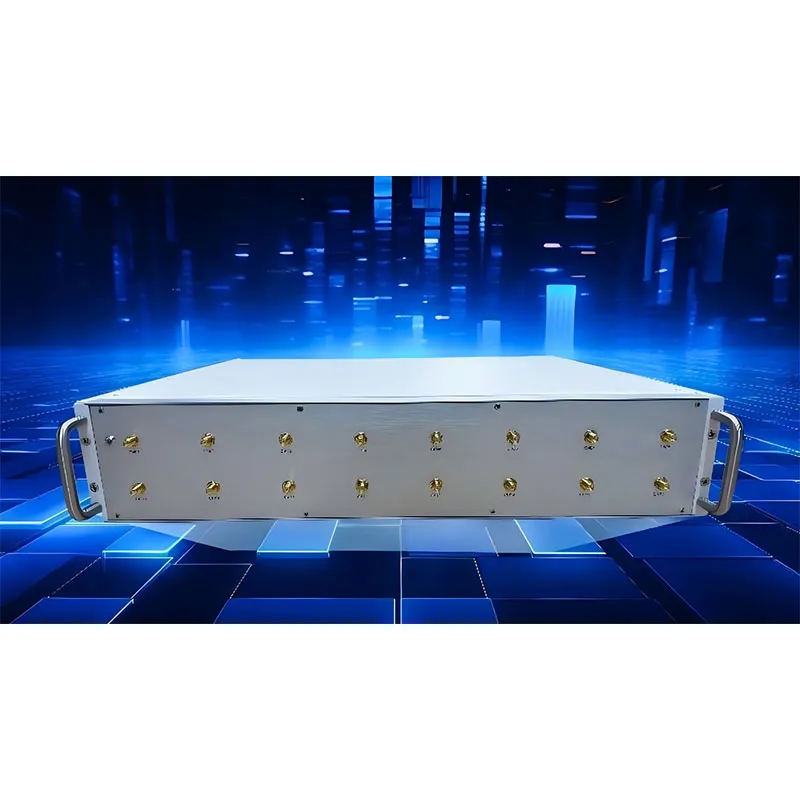

192-канальная микроволновая фотонная СВЧ-система прямой выборки NYL

192-канальная микроволновая фотонная СВЧ-система прямой выборки NYL -

SYNC_V2

SYNC_V2 -

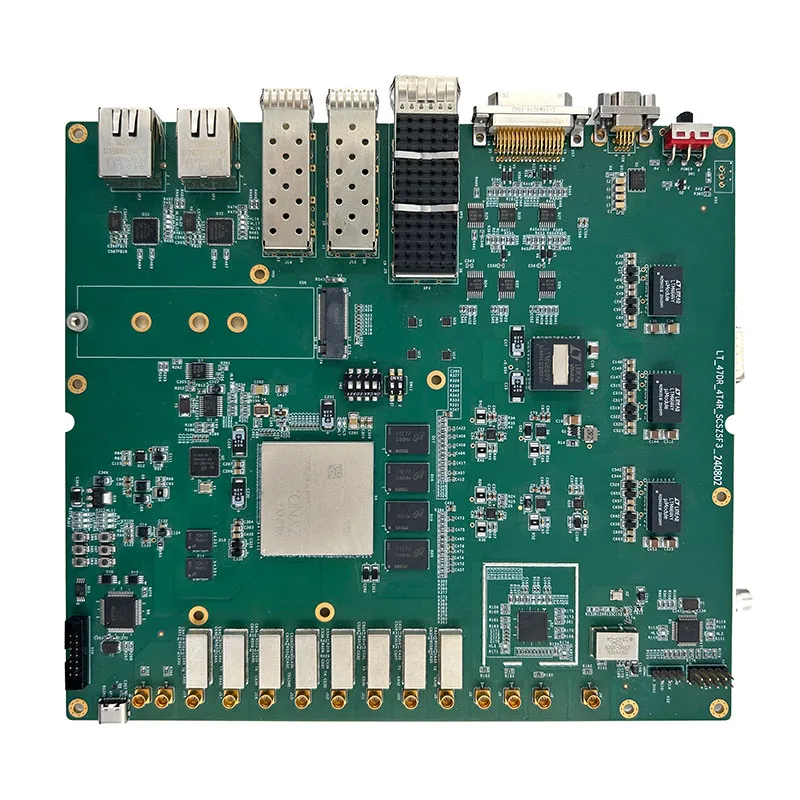

47DR_4T4R_SCSZSF3

47DR_4T4R_SCSZSF3 -

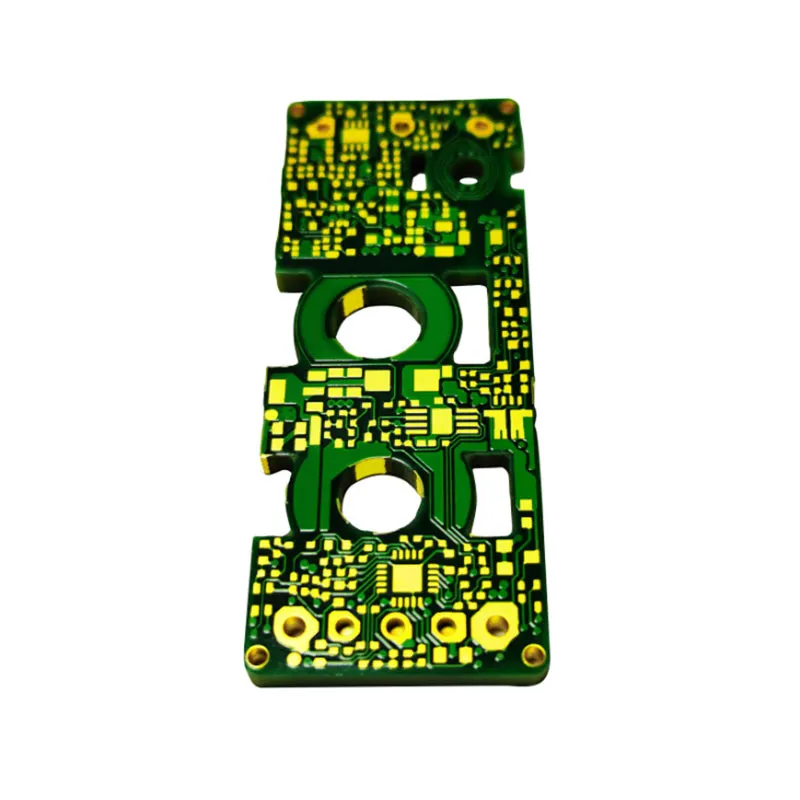

Производство и обработка PCB и SMT

Производство и обработка PCB и SMT -

От печатной платы до готового продукта: комплексные решения для производства электроники

От печатной платы до готового продукта: комплексные решения для производства электроники -

TC49DR-8T9R

TC49DR-8T9R