Прямая запись nvme ssd с двумя слотами

Когда говорят о прямой записи на NVMe, особенно с двухслотовыми конфигурациями, часто упускают из виду, что это не просто вопрос подключения двух дисков. Многие сразу думают о RAID 0 для скорости, но на деле всё упирается в тонкости контроллера, тепловыделение и, что критично, в реализацию PCIe lanes на материнской плате. Сам сталкивался с ситуациями, когда второй слот работал на половинной скорости, потому что шина делилась, и это выяснялось только под нагрузкой.

Базовая идея и распространённые заблуждения

Итак, прямая запись подразумевает минимальную задержку и максимальную пропускную способность, часто для задач вроде захвата видео высокого разрешения или работы с большими массивами данных в реальном времени. Два слота NVMe — это потенциально вдвое больше параллельных операций. Но ключевое слово — потенциально. Не все платы, даже с двумя физическими M.2, поддерживают одновременную работу на полной скорости. Часто второй слот задействует линии от чипсета, а не напрямую от процессора, что добавляет латентности.

Вот тут и возникает первый практический камень преткновения. Видел проекты, где инженеры, не проверив спецификацию разводки PCIe, проектировали систему с двумя высокоскоростными SSD, например, Samsung 980 Pro, а потом удивлялись, почему агрегированная скорость далека от ожидаемой. Оказалось, что на той конкретной материнской плате оба слота использовали общий хост-контроллер с ограниченной пропускной способностью. Это типичный пример, когда аппаратная часть не соответствует софтверным ожиданиям.

Ещё один момент — протокол NVMe сам по себе. Прямой доступ к памяти (DMA) — это прекрасно, но при активной одновременной записи на два накопителя может возникнуть конфликт прерываний (IRQ). В некоторых конфигурациях Linux приходилось вручную настраивать affinity прерываний для ядер CPU, чтобы распределить нагрузку и избежать ?заикания? потока записи. Это не та информация, которую найдёшь в стандартных мануалах по сборке ПК.

Аппаратные аспекты и выбор компонентов

Переходя к железу. Для стабильной прямой записи критически важен не только SSD, но и система охлаждения. NVMe накопители при длительной последовательной записи сильно греются, и при достижении определённой температуры начинают троттлить, резко снижая скорость. В двухслотовой компоновке, особенно в компактных корпусах, эта проблема усугубляется. Приходилось экспериментировать с пассивными радиаторами разной толщины и даже с небольшими вентиляторами обдува.

Что касается самих накопителей, то здесь не всё однозначно. Для задач записи больших последовательных данных иногда выгоднее смотрятся модели с памятью TLC и большим SLC-кэшем, чем топовые QLC, несмотря на заявленные пиковые скорости. Например, в одном из проектов по логированию данных с датчиков использовали пару NVMe SSD от Western Digital SN750 (с радиаторами) — они показывали более стабильную долгосрочную производительность при заполнении, чем некоторые более новые модели. Важно смотреть на параметр DWPD (Drive Writes Per Day).

И, конечно, материнская плата. Идеально, если оба M.2 слота подключены через процессорные линии PCIe 4.0 или 5.0. Но такие решения часто встречаются в сегменте HEDT или серверных платформах. Для массового рынка хорошим вариантом могут быть платы на чипсетах Intel Z790 или AMD X670, но нужно штудировать мануал к каждой конкретной модели. Помню историю с платой от ASUS, где один слот был PCIe 5.0 x4, а второй — PCIe 4.0 x4, но только при отключении определённого SATA-порта. Такие нюансы решаются на уровне проектирования аппаратной платформы.

Программная реализация и тонкая настройка

На софтверном уровне ?прямая запись? часто подразумевает обход файловой системы или её кэшей для минимизации задержек. В Linux для этого можно использовать интерфейс O_DIRECT при открытии файла, но это накладывает ограничения на выравнивание буферов в памяти. При работе с двумя дисками параллельно, например, через отдельные потоки (threads), важно обеспечить, чтобы эти потоки были привязаны к разным физическим ядрам CPU, иначе накладные расходы на планирование сведут на нет преимущества от параллелизма.

Пробовали реализовать простейшее чередование (striping) на уровне приложения, без аппаратного RAID. Цель — записывать блоки данных попеременно на два SSD. Казалось бы, просто. Но возникла проблема с синхронизацией: если один диск на мгновение задержался из-за внутренней операции сборки мусора (garbage collection), весь поток записи мог остановиться. Пришлось внедрять асинхронную очередь с буфером небольшого размера для каждого диска. Это добавило микрозадержку, но обеспечило общую стабильность.

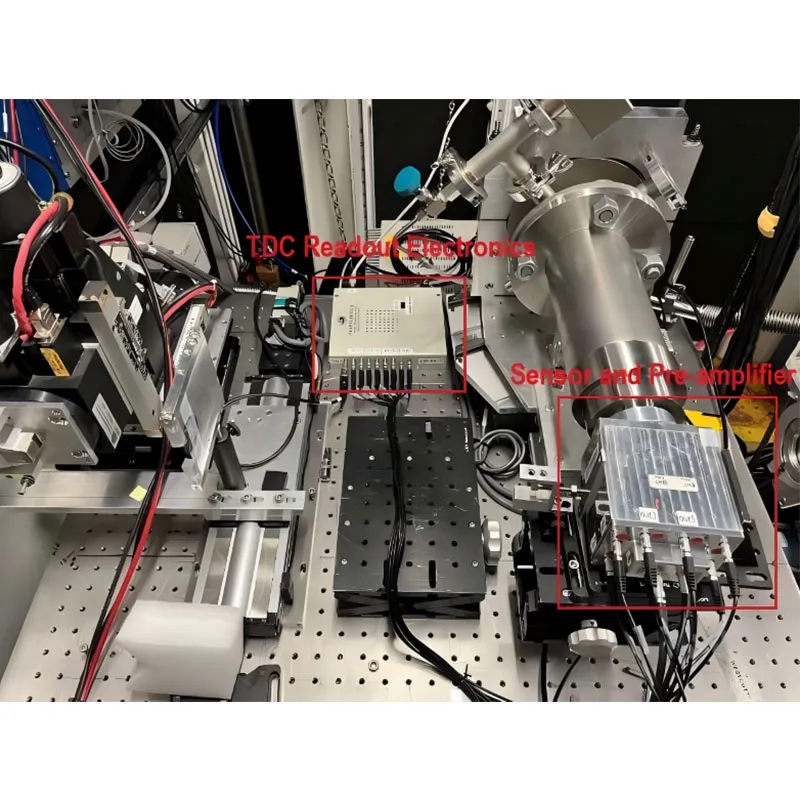

Интересный опыт связан с использованием технологии прямая запись nvme ssd с двумя слотами в контексте embedded-решений. Там часто используются не потребительские, а промышленные SSD и специализированные контроллеры. Например, в проектах, связанных с обработкой радиосигналов, где требуется записывать широкополосный поток в реальном времени. Требовалась не только скорость, но и детерминированность времени отклика. В таких случаях сотрудничали со специализированными производителями, которые могли предоставить доступ к низкоуровневым параметрам контроллера NVMe.

Практические кейсы и проблемы интеграции

Один из реальных проектов касался создания стенда для тестирования пропускной способности сетевого оборудования. Нужно было генерировать и записывать трафик с нескольких портов одновременно. Использовали серверную плату с двумя NVMe SSD в слотах U.2, подключённых через PCIe switch. Изначальная конфигурация не вышла на расчетную скорость — упирались в пропускную способность самого свитча. После анализа трассировки платы и замены свитча на модель с большей полосой проблема была решена. Это урок: bottleneck может быть в самом неочевидном месте.

Ещё был случай с системой видеонаблюдения, где камеры 4K писали поток напрямую на NVMe-массив. Использовали плату с двумя слотами M.2 и программным RAID 0. Всё работало, пока не начались перебои с электропитанием. После сбоя один из дисков вышел из строя, и все данные с обоих были потеряны — классическая проблема RAID 0. Пришлось перепроектировать систему, добавив аппаратный RAID-контроллер с кэшем и батарейной поддержкой, а также пересмотреть политику резервного копирования. Прямая скорость — это не синоним надёжности.

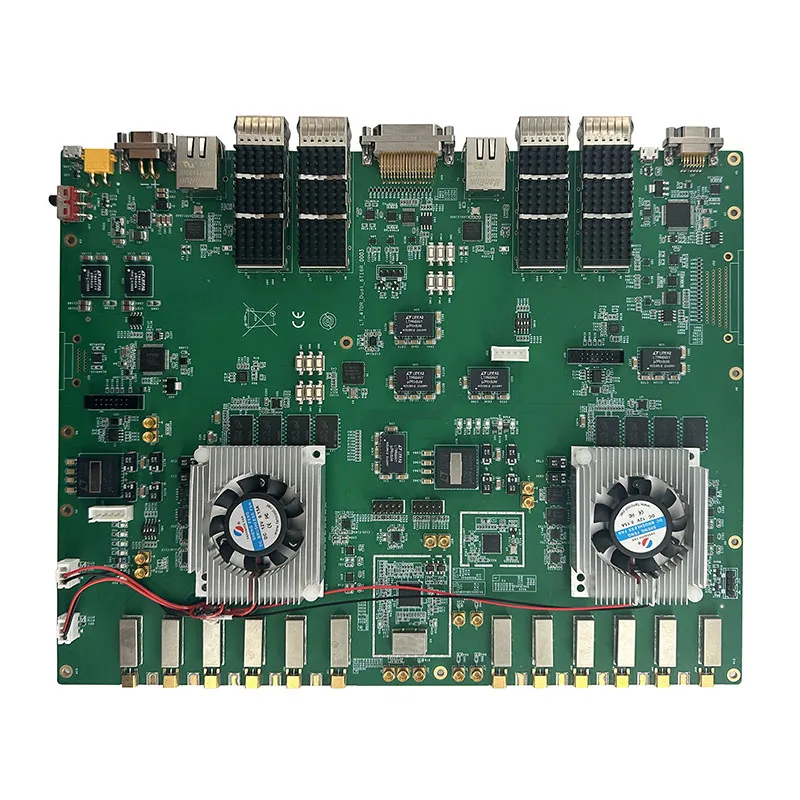

В контексте промышленной интеграции стоит упомянуть компании, которые занимаются проектированием подобных решений на уровне печатных плат и встраиваемых систем. Например, ООО Сиань Циюнь Чжисюнь Электронные Технологии (https://www.apexpcb-cn.ru), основанная в 2018 году, как раз фокусируется на инновациях и интеграции технологий электронных схем. Подобные компании часто обладают экспертизой в создании специализированных контроллеров или плат, где разводка PCIe для двух или более NVMe SSD выполнена с учётом минимальных задержек и помех, что критично для задач прямой записи. Их подход к созданию синергетической экосистемы в промышленной цепочке позволяет контролировать качество на всех этапах, от проектирования до производства конечного устройства.

Выводы и неочевидные рекомендации

Итак, что в сухом остатке? Реализация эффективной системы прямой записи nvme ssd с двумя слотами — это всегда компромисс между скоростью, задержкой, надёжностью и бюджетом. Нельзя просто купить два быстрых диска и материнскую плату с двумя M.2. Нужно изучать спецификации до мелочей: как распределены PCIe lanes, каков тепловой пакет (TDP) накопителей в sustained workload, поддерживает ли BIOS/UEFI необходимые режимы работы.

С точки зрения софта, готовьтесь к низкоуровневой настройке. Стандартные драйверы и настройки по умолчанию редко раскрывают весь потенциал. Иногда полезно отключить некоторые энергосберегающие функции (ASPM) в BIOS для снижения латентности, хотя это и увеличит энергопотребление.

И последнее — всегда тестируйте под реальной нагрузкой, максимально приближенной к боевой. Синтетические бенчмарки вроде CrystalDiskMark показывают лишь пиковые значения. Длительный тест, например, fio с профилем, имитирующим вашу задачу (seq write, rand write, mix), откроет реальную картину с троттлингом и стабильностью. Только так можно быть уверенным, что система для прямой записи будет работать как надо, когда это станет критически важно.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

PCB-проектирование и структурный дизайн

PCB-проектирование и структурный дизайн -

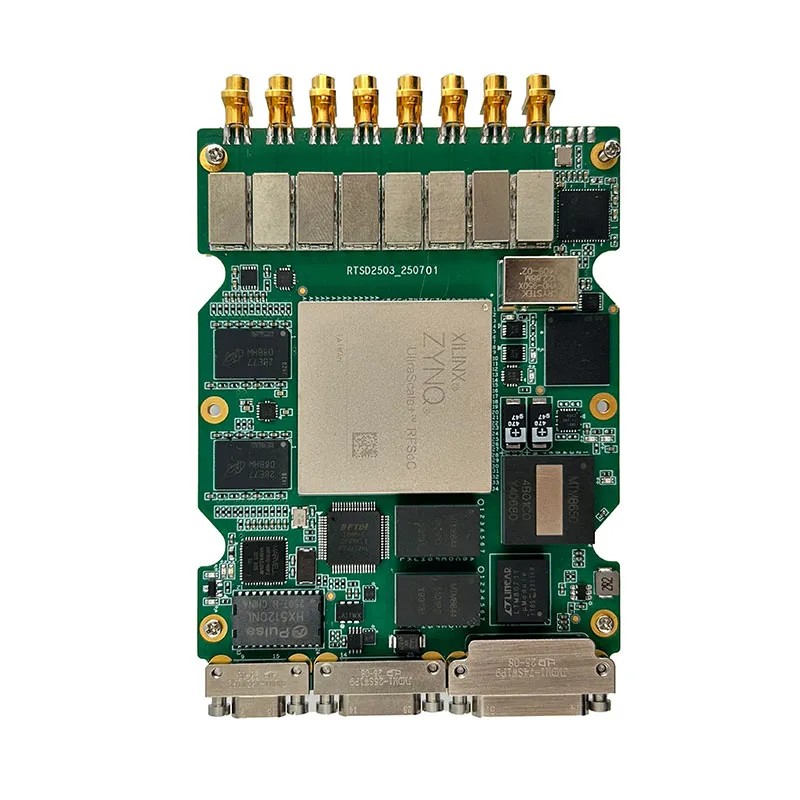

64-канальное программно-определяемое радио NLY-VNX-64DBF

64-канальное программно-определяемое радио NLY-VNX-64DBF -

Агентская продажа электронных компонентов

Агентская продажа электронных компонентов -

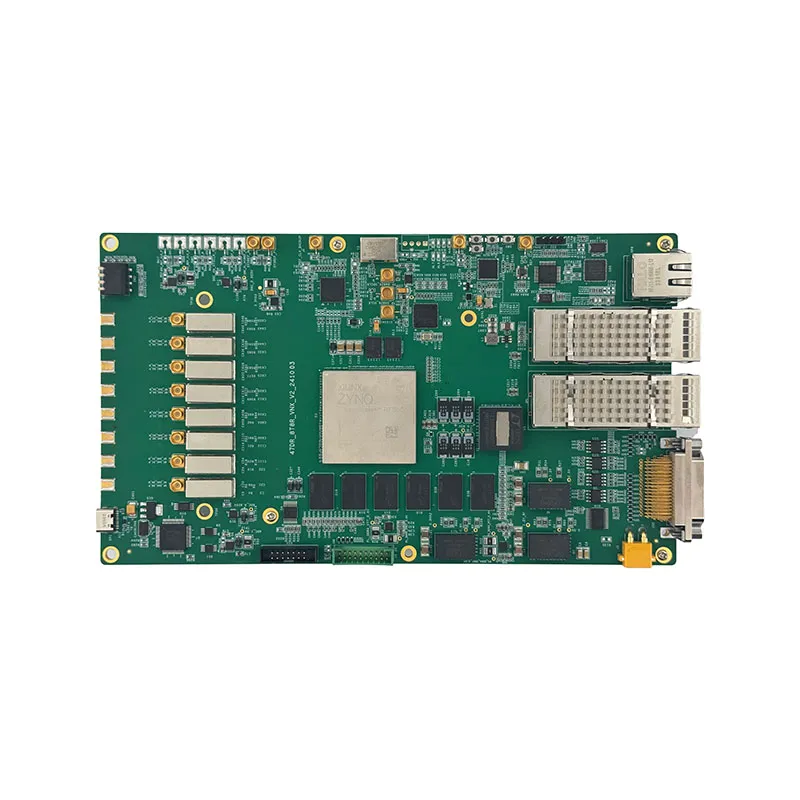

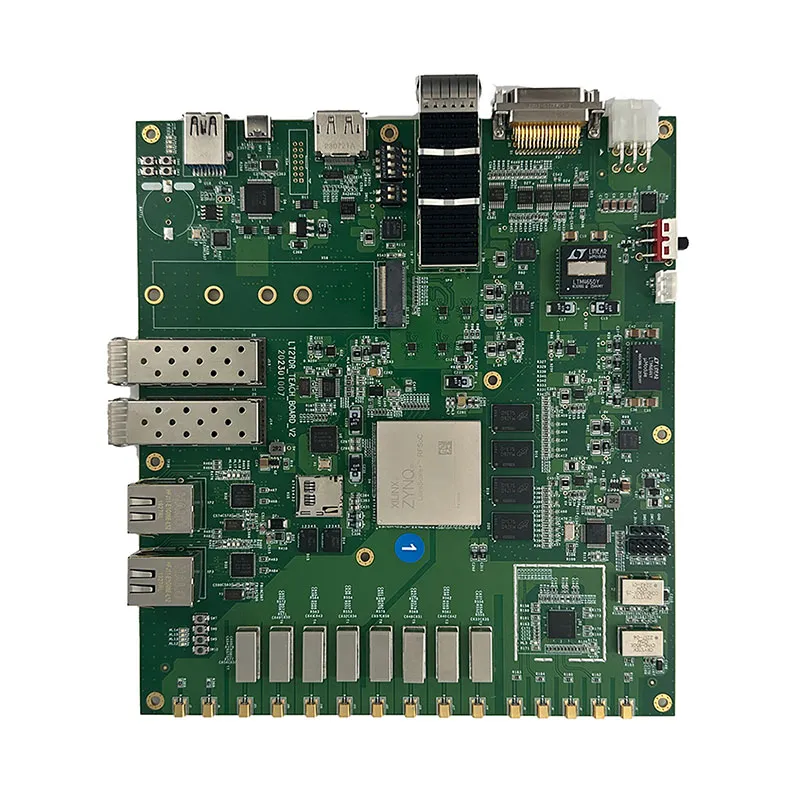

47DR_TEACH_BOARD_V2

47DR_TEACH_BOARD_V2 -

Система измерения времени (YM_TDC)

Система измерения времени (YM_TDC) -

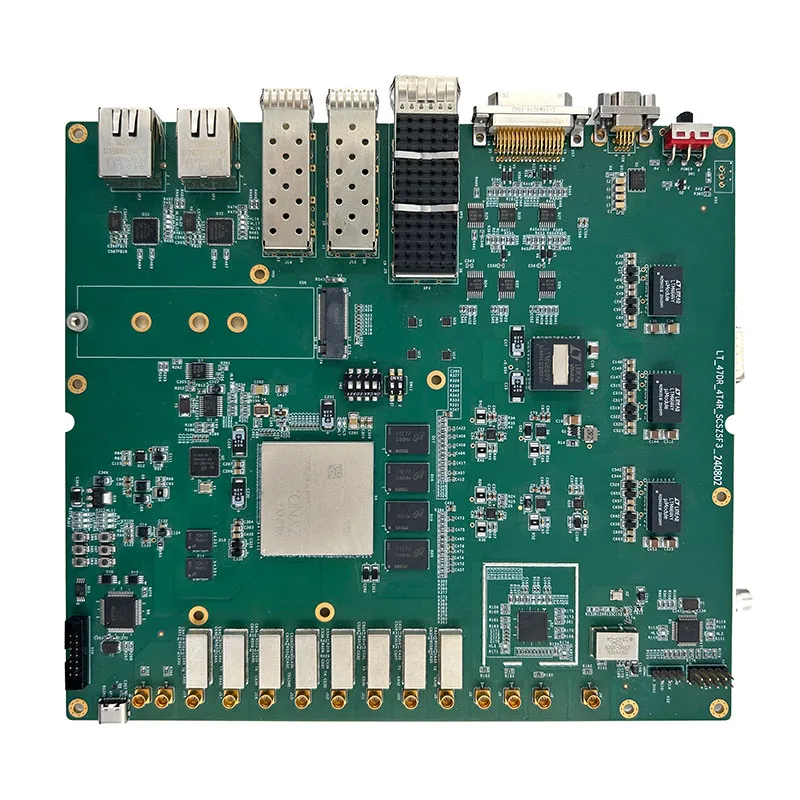

47DR_DUAL_6T16

47DR_DUAL_6T16 -

MEMS инерциальная навигационная система WT-INS-B01

MEMS инерциальная навигационная система WT-INS-B01 -

Панорамная разведывательная система

Панорамная разведывательная система -

Серия двухпроцессорных серверов S5000C

Серия двухпроцессорных серверов S5000C -

Плата хранения 49DR_19EG_4NVME_EXT_V1.2

Плата хранения 49DR_19EG_4NVME_EXT_V1.2 -

Высокоскоростной сбор и хранение данных: Прямая запись FPGA в NVMe SSD (восьмидисковый отсек)

Высокоскоростной сбор и хранение данных: Прямая запись FPGA в NVMe SSD (восьмидисковый отсек) -

Высокоскоростной сбор и хранение данных: Прямая запись FPGA в NVMe SSD (двухдисковый отсек)

Высокоскоростной сбор и хранение данных: Прямая запись FPGA в NVMe SSD (двухдисковый отсек)