Компьютер

Когда говорят ?компьютер?, многие до сих пор представляют системный блок, монитор, клавиатуру. Это, конечно, верно, но лишь на поверхности. В нашей работе — проектировании и поставке сложных электронных компонентов — это понятие давно размылось. Компьютер сегодня — это и сервер в стойке, обрабатывающий файлы для производства печатных плат, и встроенный контроллер на этой самой плате, и даже симулятор, в котором мы проверяем разводку сигналов до отправки заказа на завод. Основная ошибка новичков в отрасли — считать его чем-то отдельным, конечным продуктом. Нет, это всегда часть экосистемы, часто невидимая. У нас в компании, ООО ?Сиань Циюнь Чжисюнь Электронные Технологии?, это понимание пришло не сразу. В начале, в годах, мы тоже закупали мощные рабочие станции для инженеров, думая, что вопрос решен. Но оказалось, что ключевой компьютер — это тот, что управляет всей цепочкой данных от схемы до готового изделия.

Железо как ограничивающий фактор

Вот конкретный пример из практики. Мы получили заказ на разработку многослойной платы для системы промышленной автоматизации. Инженер смоделировал тепловыделение на своем локальном ПК, все выглядело хорошо. Но когда дело дошло до полного электромагнитного анализа в рамках более крупного узла, его машина просто зависла. Не хватило оперативной памяти. Пришлось срочно переносить задачи на наш внутренний серверный кластер. Это был момент истины: производительность компьютера напрямую определяет глубину анализа, а значит, и надежность конечного продукта. Мы начали инвестировать не в отдельные мощные машины, а в распределенные вычислительные ресурсы.

Это привело к другому казусу. Купили, как нам казалось, отличные серверы. Но софт для симуляции сигнальной целостности, который мы используем, оказался сильно оптимизирован под конкретные конфигурации процессоров. Наши новые Xeon давали прирост в 15%, а не в 40%, как мы ожидали. Пришлось углубляться в спецификации, советоваться с коллегами из других компаний группы. Выяснилось, что для наших задач лучше подходят немного другие серии. Обидный урок: нельзя выбирать оборудование, просто глядя на гигагерцы и гигабайты. Контекст — все.

Сейчас мы часть расчетов перенесли в облако, но не все. Данные по некоторым проектам, особенно связанным с нашими партнерами по цепочке, не могут покидать локальный периметр. Поэтому гибридная модель: легкие задачи — локально, тяжелые симуляции — на удаленных мощностях, но на арендованных выделенных нодах, а не на публичных. Управлять этим балансом — отдельная головная боль для системного администратора. Иногда проще купить еще один сервер, чем разбираться с настройками виртуальных машин и задержками сети.

Софт: где кроется реальная стоимость

Говоря о компьютере в нашем деле, нельзя не сказать про ПО. Лицензии на профессиональные САПР (системы автоматизированного проектирования) и симуляторы стоят космических денег. Одна лицензия на год может стоить как десяток высококлассных рабочих станций. И вот здесь начинается тонкая игра. Нужно точно рассчитать, сколько инженерам нужно ?мест? для, скажем, Altium Designer или Cadence, а сколько можно обойтись более легкими или вьюверными версиями.

У нас был неудачный опыт, когда мы купили на всю команду лицензии ?полного цикла?. Оказалось, что часть сотрудников, отвечающих за подготовку производственных файлов (герберы, сверловка), просто не используют 90% функционала. Деньги ушли впустую. Теперь мы дробим: у ключевых разработчиков — максимальный пакет, у технологов — специализированный софт для DFM-анализа (анализ технологичности конструкции), у менеджеров — только вьюверы для проверки. Это экономит значительные средства, которые можно направить на обновление ?железа? для тех, кому это критично.

Еще один момент — совместимость. Файл проекта, созданный в одной версии программы, может некорректно открыться в другой. Мы работаем с заводами, которые могут использовать другое ПО. Поэтому наш внутренний стандарт — всегда экспортировать в ?нейтральные? форматы (например, STEP для 3D-моделей), даже если это немного увеличивает время работы. Компьютер должен выполнять эту конвертацию быстро и без ошибок. Мы даже написали несколько скриптов для автоматизации таких рутинных операций, что разгрузило инженеров.

Интеграция в производственную цепочку

Вот здесь роль компьютера становится абсолютно конкретной. Наш сайт, https://www.apexpcb-cn.ru, — это лишь витрина. Его бэкенд — это сложная система, которая принимает заказ, привязывает его к спецификациям, резервирует материалы на складах наших партнерских заводов и формирует задание для производства. Вся эта цепочка управляется компьютерами, и сбой на любом этапе ведет к задержкам.

Помню случай, когда мы внедряли новую MES-систему (система управления производственными процессами) на одном из участвующих предприятий. Данные с наших проектных серверов должны были напрямую поступать в цех. Но из-за разницы в сетевых протоколах и настройках firewall информация терялась. Два дня ушло не на саму интеграцию, а на отладку связи между двумя, казалось бы, стандартными промышленными компьютерами. Решение оказалось простым — настроить промежуточный сервер-буфер, но чтобы это понять, пришлось перерыть кучу документации.

Сейчас экосистема нашей группы компаний построена так, чтобы данные текли с минимальным человеческим вмешательством. От идеи схемы — к симуляции, от симуляции — к разводке печатной платы, от платы — к программе для станков с ЧПУ на заводе. Каждый шаг выполняется на своем специализированном компьютере или кластере, но они должны идеально понимать друг друга. Это и есть та самая ?синергетическая экосистема промышленной цепочки?, о которой говорится в описании компании. Без грамотно выстроенной ИТ-инфраструктуры это просто красивые слова.

Надежность и отказоустойчивость

В промышленной электронике простои — это прямые убытки. Поэтому вопрос надежности компьютера выходит на первый план. Мы перестали использовать потребительские видеокарты для расчетов, перейдя на профессиональные серии (Nvidia Quadro, AMD Radeon Pro). Не потому, что они намного быстрее, а потому, что их драйверы оптимизированы для длительных непрерывных вычислений и имеют лучшую поддержку ECC-памяти. Ошибка в одном бите при симуляции может привести к ложному положительному результату и браку в производстве.

Системы хранения данных — отдельная история. После одного инцидента с выходом из строя диска на основном файловом сервере (к счастью, бэкапы были), мы перешли на схему RAID 10 + регулярное резервное копирование на отдельный физический накопитель и в удаленное хранилище. Это дороже, но спокойствие дороже. Все критичные машины, включая те, что управляют работой нашего сайта и CRM, задублированы.

Интересно, что иногда самые простые вещи подводят. Например, блоки питания. В одном из наших серверных шкафов стояли качественные, но недостаточно мощные ИБП. При скачке напряжения они не выдержали, и кластер ушел в перезагрузку. Прервался долгий расчет, потерялось полдня работы. Теперь при проектировании ИТ-инфраструктуры мы закладываем запас по мощности в 30-40%, и это касается не только электрики, но и систем охлаждения. Перегрев — тихий убийца производительности.

Будущее: специализация и конвергенция

Куда движется все это? Мне кажется, что универсальный компьютер в нашем секторе окончательно умрет. Будут узкоспециализированные вычислительные модули: один — для задач САПР с упором на графику, другой — для математических симуляций с огромным объемом ОЗУ, третий — для управления сборочными линиями с гарантированным временем отклика (real-time системы). Но управляться они будут из единой среды.

Уже сейчас мы экспериментируем с контейнеризацией софта. Инженер запускает на своем относительно слабом терминале контейнер, в котором развернута нужная версия САПР со всеми библиотеками и настройками. Сам расчет может выполняться на удаленном сервере. Это дает гибкость и избавляет от проблем ?а у меня на компьютере не запускается?.

В итоге, возвращаясь к началу. Компьютер для нас — это не предмет. Это инфраструктура, среда, условие работы. Его нельзя просто купить и забыть. Его нужно постоянно настраивать, адаптировать, масштабировать и защищать. Успех в разработке электроники, как демонстрирует опыт нашей растущей группы компаний, все меньше зависит от гения одного инженера и все больше — от слаженной работы целой цифровой экосистемы, где каждый винтик, каждая машина, знает свое место. И пишется это все не для красоты, а из ежедневной практики, иногда довольно болезненной.

Соответствующая продукция

Соответствующая продукция

Самые продаваемые продукты

Самые продаваемые продукты-

Высокоскоростной регистратор данных

Высокоскоростной регистратор данных -

47DR-4T8R_LBV

47DR-4T8R_LBV -

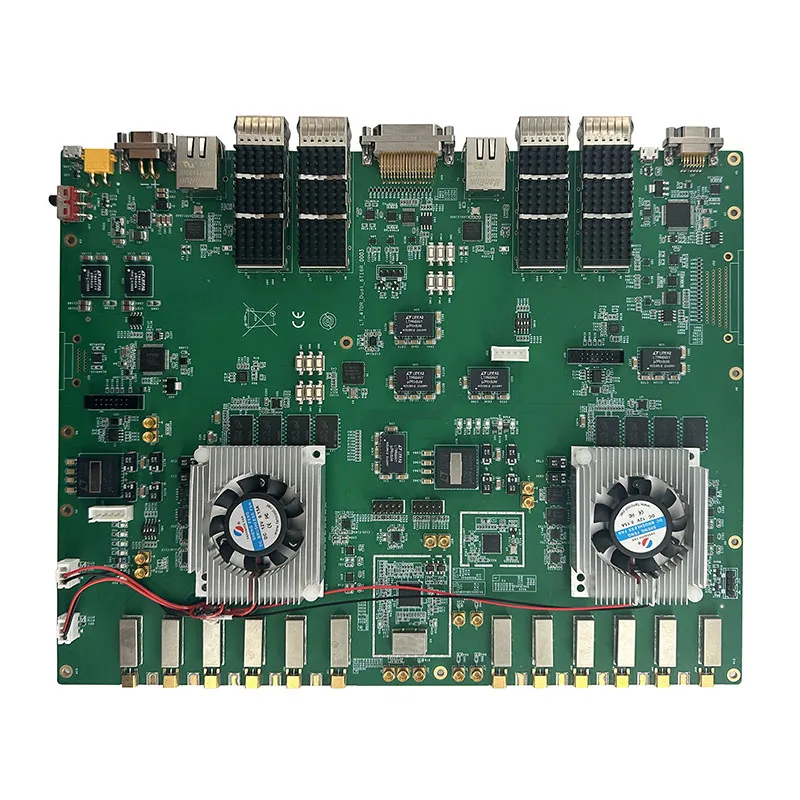

Вычислительная мощность платы FPGA+TX2i GPU составляет 40 TOPS

Вычислительная мощность платы FPGA+TX2i GPU составляет 40 TOPS -

Устройство экстренной кнопки SOS

Устройство экстренной кнопки SOS -

Высокоскоростной сбор и хранение данных: Прямая запись FPGA в NVMe SSD (двухдисковый отсек)

Высокоскоростной сбор и хранение данных: Прямая запись FPGA в NVMe SSD (двухдисковый отсек) -

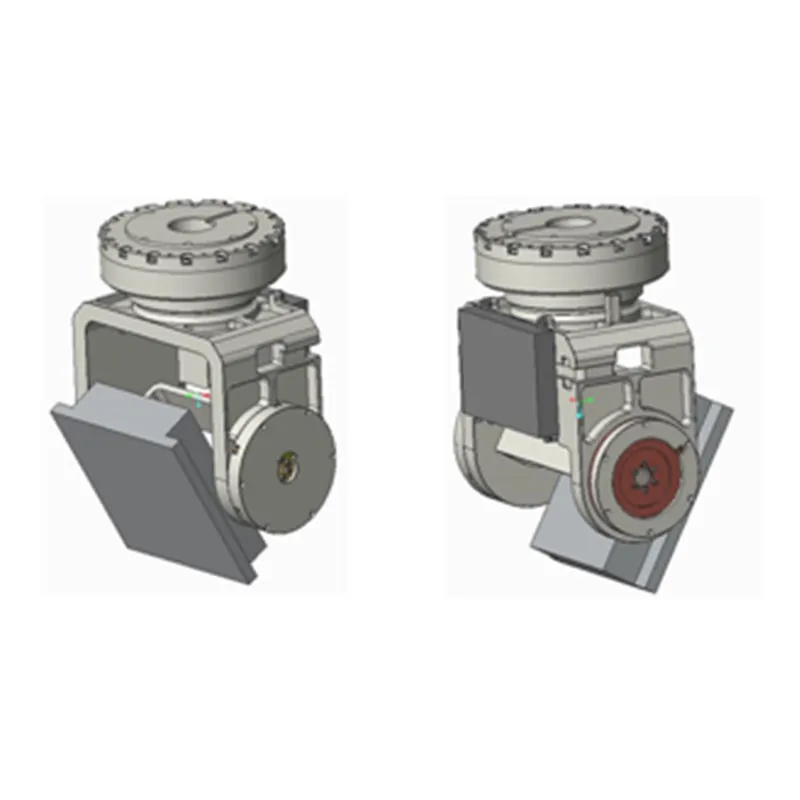

Панорамная разведывательная система

Панорамная разведывательная система -

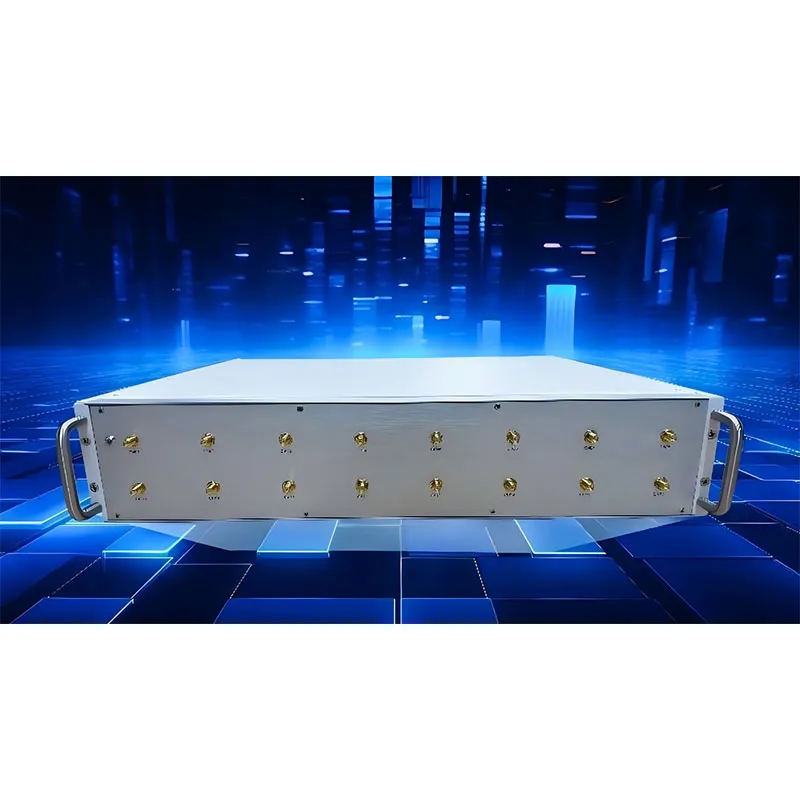

Программно-определяемое радио 4xAD9361

Программно-определяемое радио 4xAD9361 -

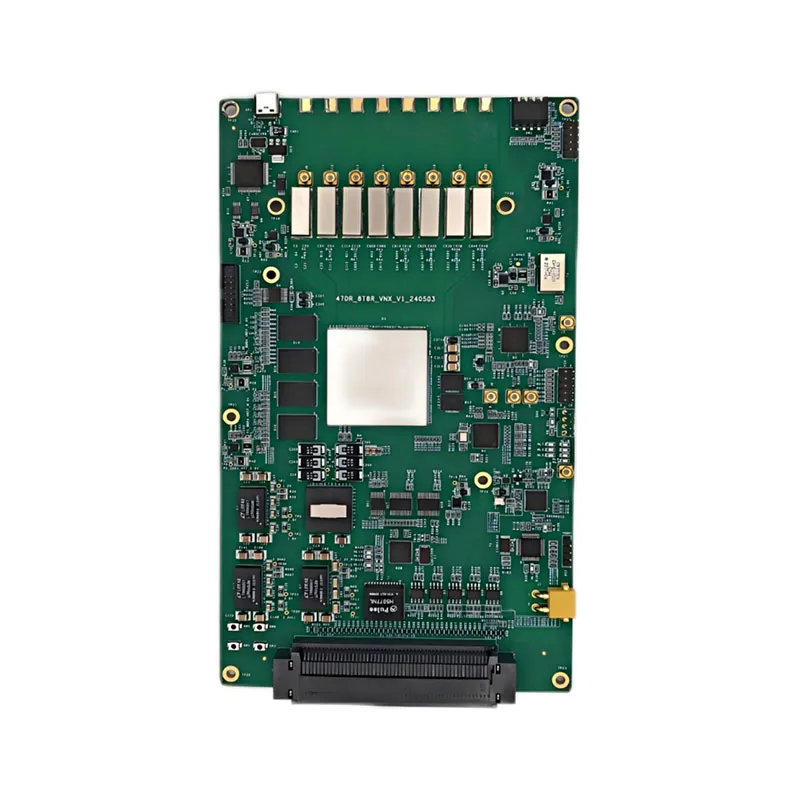

Высокоскоростной сбор и хранение данных: Прямая запись FPGA в NVMe SSD (восьмидисковый отсек)

Высокоскоростной сбор и хранение данных: Прямая запись FPGA в NVMe SSD (восьмидисковый отсек) -

47DR_8T8R_VNX_V1

47DR_8T8R_VNX_V1 -

Плата обработки сигналов VU13P-FMC

Плата обработки сигналов VU13P-FMC -

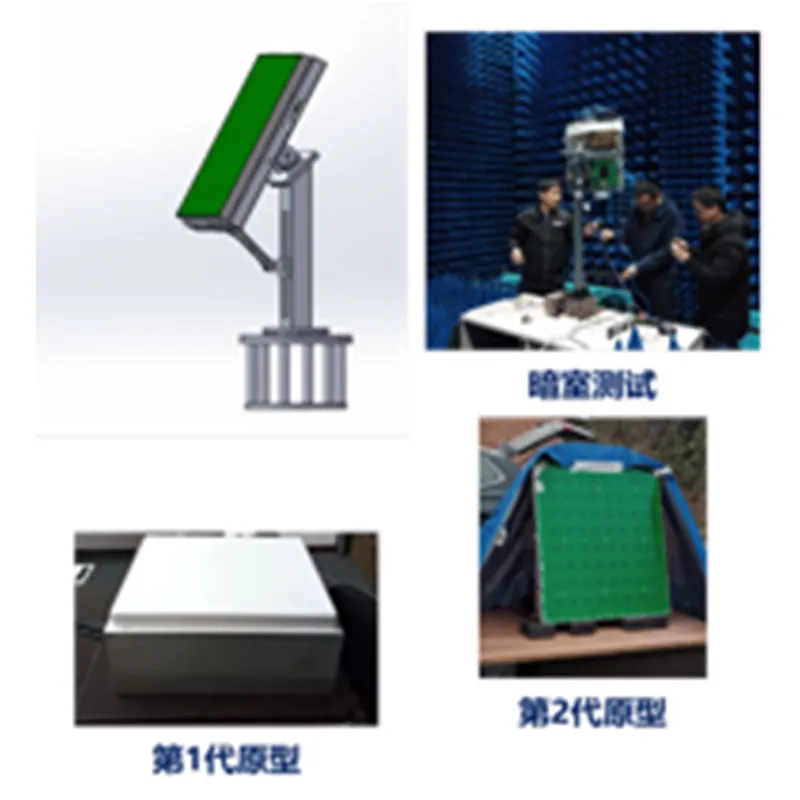

8T8R прототип программируемой РЛС

8T8R прототип программируемой РЛС -

16T16R прототип программируемой РЛС

16T16R прототип программируемой РЛС